DifFlow3D:场景流估计新SOTA,扩散模型又下一城!

发布于2024-12-22 阅读(0)

发布于2024-12-22 阅读(0)

扫一扫,手机访问

原标题:DifFlow3D: Toward Robust Uncertainty-Aware Scene Flow Estimation with Iterative Diffusion-Based Refinement

论文链接:https://arxiv.org/pdf/2311.17456.pdf

代码链接:https://github.com/IRMVLab/DifFlow3D

作者单位:上海交通大学 剑桥大学 浙江大学 鉴智机器人

论文思路:

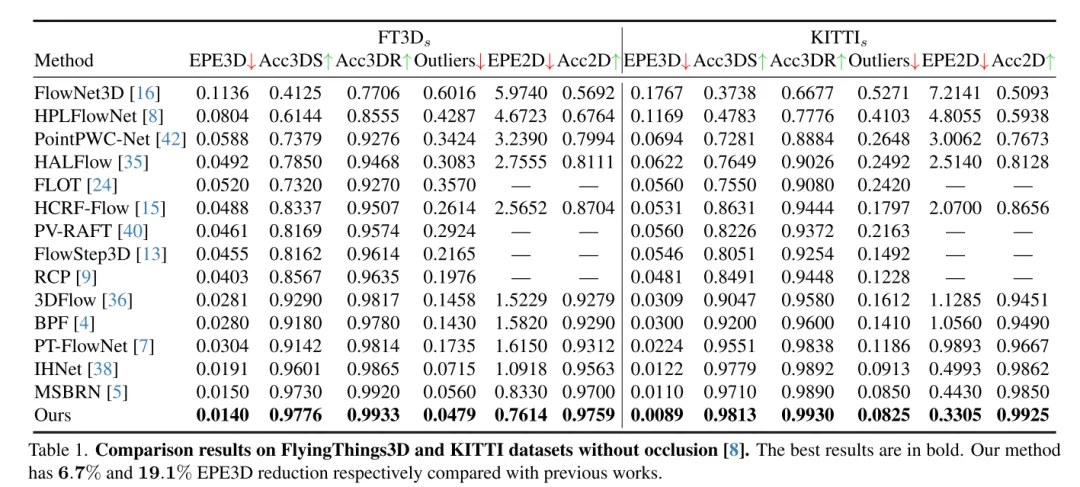

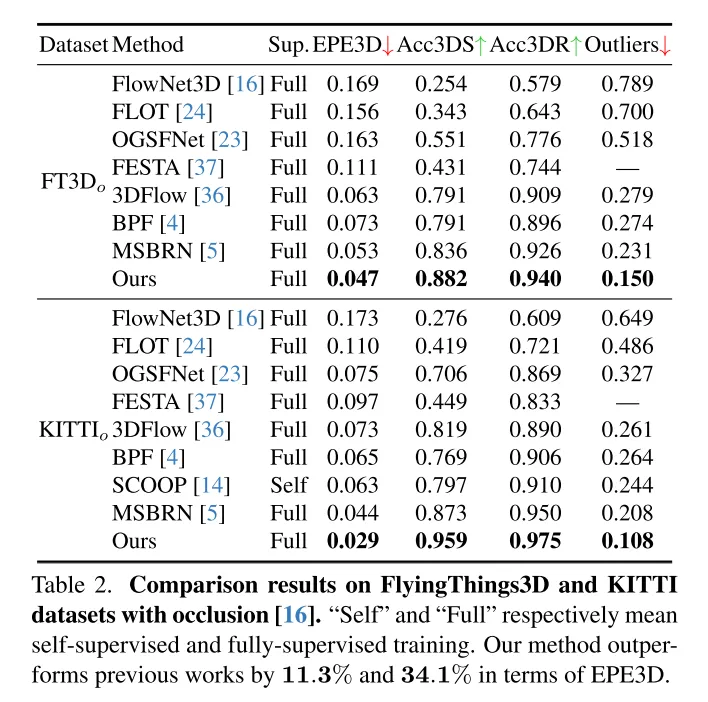

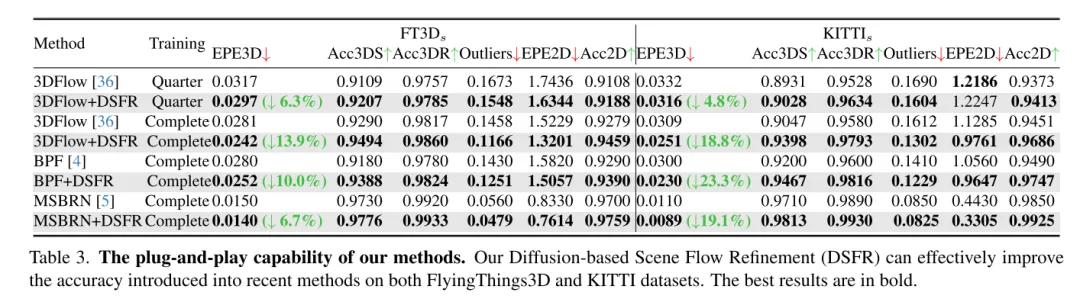

场景流估计旨在预测动态场景中每个点的3D位移变化,是计算机视觉领域的一个基础任务。然而,以往的工作常常受到局部约束搜索范围引起的不可靠相关性的困扰,并且在从粗到细的结构中积累不准确性。为了缓解这些问题,本文提出了一种新颖的不确定性感知场景流估计网络(DifFlow3D),该网络采用了扩散概率模型。设计了迭代扩散式细化(Iterative diffusion-based refinement)来增强相关性的鲁棒性,并对困难情况(例如动态、噪声输入、重复模式等)具有较强的适应性。为了限制生成的多样性,本文的扩散模型中利用了三个关键的与流相关的特征作为条件。此外,本文还在扩散中开发了一个不确定性估计模块,以评估估计场景流的可靠性。本文的 DifFlow3D 在 FlyingThings3D 和 KITTI 2015 数据集上分别实现了6.7%和19.1%的三维端点误差(EPE3D)降低,并在KITTI数据集上实现了前所未有的毫米级精度(EPE3D为0.0089米)。另外,本文的基于扩散的细化范式可以作为一个即插即用的模块,轻松集成到现有的场景流网络中,显著提高它们的估计精度。

主要贡献:

为了实现稳健的场景流估计,本研究提出了一种全新的即插即用型基于扩散的细化流程。据我们所知,这是首次在场景流任务中采用扩散概率模型。

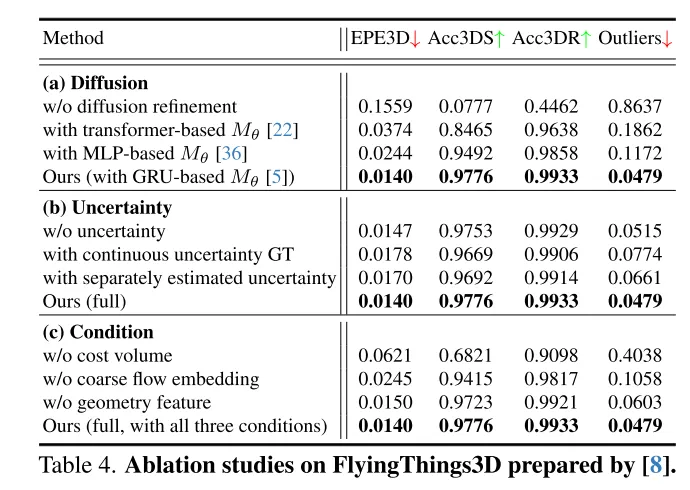

作者结合了粗流嵌入、几何编码和跨帧成本体积等技术,设计了一种有效的条件引导方法,用于控制生成结果的多样性。

为了评估本文中流的可靠性并识别不准确的点匹配,作者还在扩散模型中引入了每个点的不确定性估计。

研究结果表明,本文提出的方法在FlyingThings3D和KITTI数据集上表现优异,胜过其他现有方法。特别是,DifFlow3D在KITTI数据集上实现了毫米级的端点误差(EPE3D),这是首次。相较于以往的研究,本文的方法在处理具有挑战性的情况时表现更为鲁棒,如噪声输入和动态变化。

网络设计:

场景流作为计算机视觉中的一项基础任务,指的是从连续的图像或点云中估计出的三维运动场。它为动态场景的低层次感知提供了信息,并且有着各种下游应用,例如自动驾驶[21]、姿态估计[9]和运动分割[1]。早期的工作集中在使用立体[12]或RGB-D图像[10]作为输入。随着3D传感器,例如激光雷达的日益普及,近期的工作通常直接以点云作为输入。

作为开创性的工作,FlowNet3D[16]使用 PointNet++[25] 提取层次化特征,然后迭代回归场景流。PointPWC[42] 通过金字塔、变形和成本体积结构[31]进一步改进了它。HALFlow[35] 跟随它们,并引入了注意力机制以获得更好的流嵌入。然而,这些基于回归的工作通常遭受不可靠的相关性和局部最优问题[17]。原因主要有两个方面:(1)在他们的网络中,使用K最近邻(KNN)来搜索点对应关系,这并不能考虑到正确但距离较远的点对,也存在匹配噪声[7]。(2)另一个潜在问题来自于以往工作[16, 35, 36, 42]中广泛使用的粗到细结构。基本上,最初的流在最粗糙的层上估计,然后在更高分辨率中迭代细化。然而,流细化的性能高度依赖于初始粗流的可靠性,因为后续的细化通常受限于初始化周围的小的空间范围内。

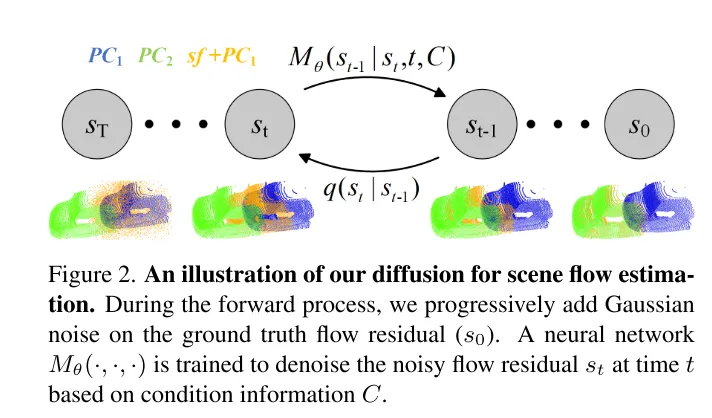

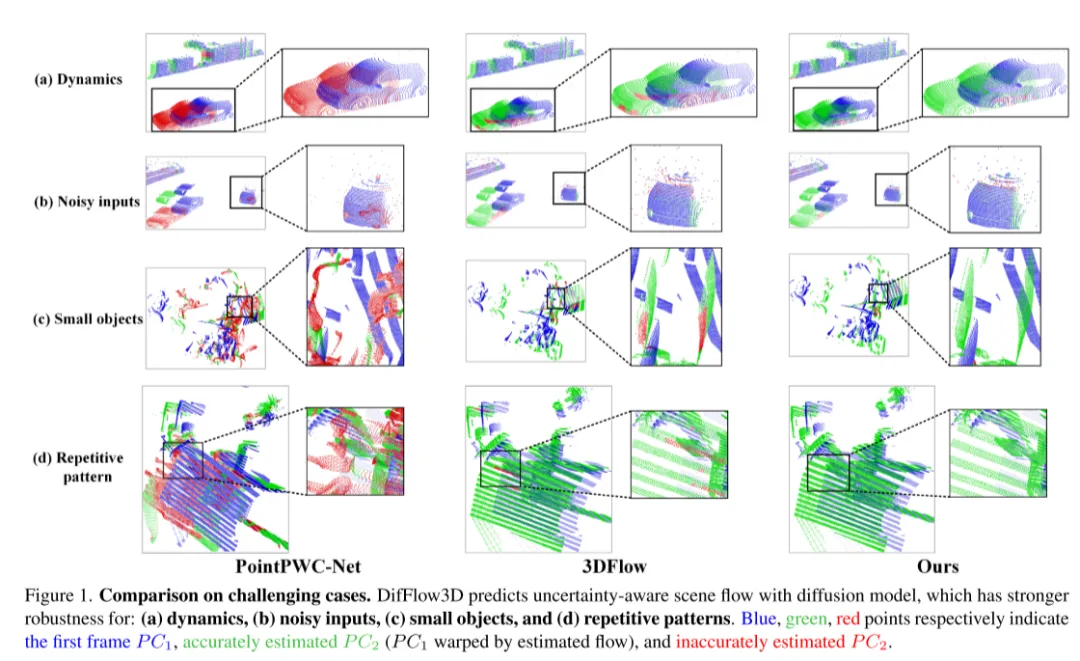

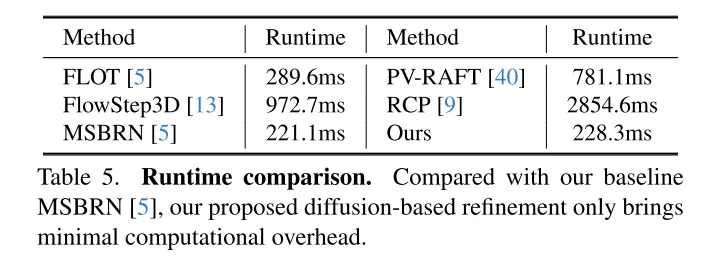

为了解决不可靠性的问题,3DFlow[36] 设计了一个 all-to-all 的点收集模块,并加入了反向验证。类似地,Bi-PointFlowNet[4] 及其扩展MSBRN[5] 提出了一个双向网络,具有前向-后向相关性。IHNet[38] 利用一个带有高分辨率引导和重采样方案的循环网络。然而,这些网络大多因其双向关联或循环迭代而在计算成本上遇到了困难。本文发现扩散模型也可以增强相关性的可靠性和对匹配噪声的韧性,这得益于其去噪本质(如图1所示)。受到[30]中的发现的启发,即注入随机噪声有助于跳出局部最优,本文用概率扩散模型重新构建了确定性流回归任务(deterministic flow regression task),如图2所示。此外,本文的方法可以作为一个即插即用的模块服务于先前的场景流网络,这种方法更为通用,并且几乎不增加计算成本(第4.5节)。

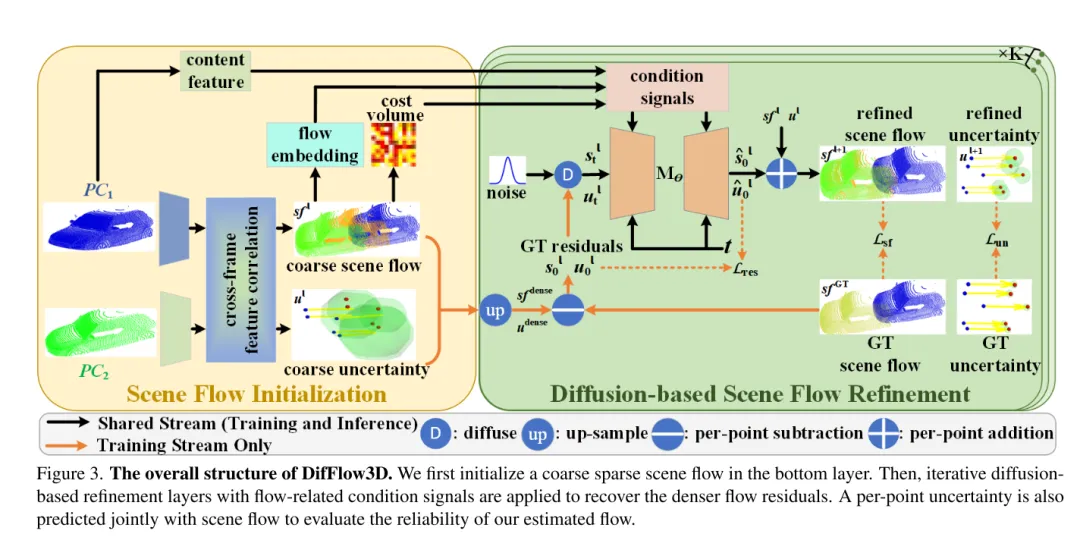

然而,在本文的任务中利用生成模型是相当具有挑战性的,因为扩散模型固有的生成多样性。与需要多样化输出样本的点云生成任务不同,场景流预测是一个确定性任务,它计算精确的每点运动向量。为了解决这个问题,本文利用强条件信息来限制多样性,并有效控制生成的流。具体来说,首先初始化一个粗糙的稀疏场景流,然后通过扩散迭代生成流残差(flow residuals)。在每个基于扩散的细化层中,本文利用粗流嵌入、成本体积和几何编码作为条件。在这种情况下,扩散被应用于实际学习从条件输入到流残差的概率映射。

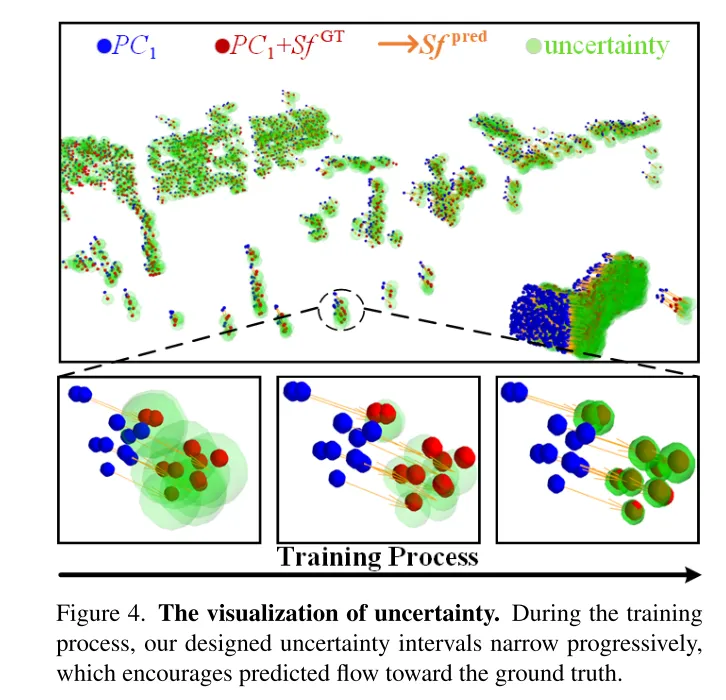

此外,先前的工作很少探索场景流估计的置信度和可靠性。然而,如图1所示,在噪声、动态变化、小物体和重复模式的情况下,密集流匹配容易出错。因此,了解每个估计的点对应关系是否可靠是非常重要的。受到最近在光流任务中不确定性估计成功的启发[33],本文在扩散模型中提出了逐点不确定性,以评估本文的场景流估计的可靠性。

图3。DifFlow3D 的总体结构。本文首先在 bottom layer 初始化一个粗糙的稀疏场景流。随后,将迭代扩散式细化层与流相关的条件信号结合使用,以恢复更密集的流残差。为了评估本文估计的流的可靠性,还将与场景流一起联合预测每个点的不确定性。

图2。本文用于场景流估计的扩散过程示意图。

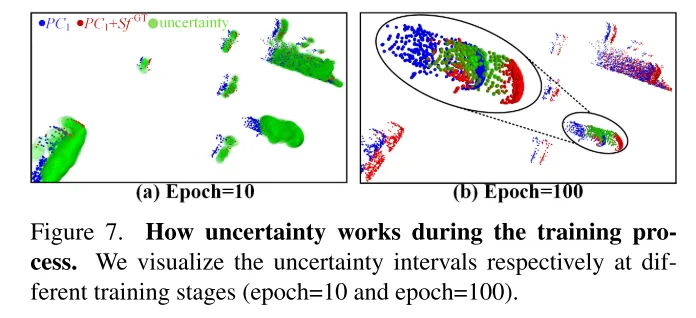

图4。不确定性的可视化。在训练过程中,本文设计的不确定性区间逐渐缩小,这促使预测的流向真实值靠拢。

实验结果:

图1。在具有挑战性的情况下的比较。DifFlow3D 使用扩散模型预测具有不确定性感知的场景流,该模型对以下情况具有更强的鲁棒性:(a)动态变化,(b)噪声干扰的输入,(c)小物体,以及(d)重复模式。

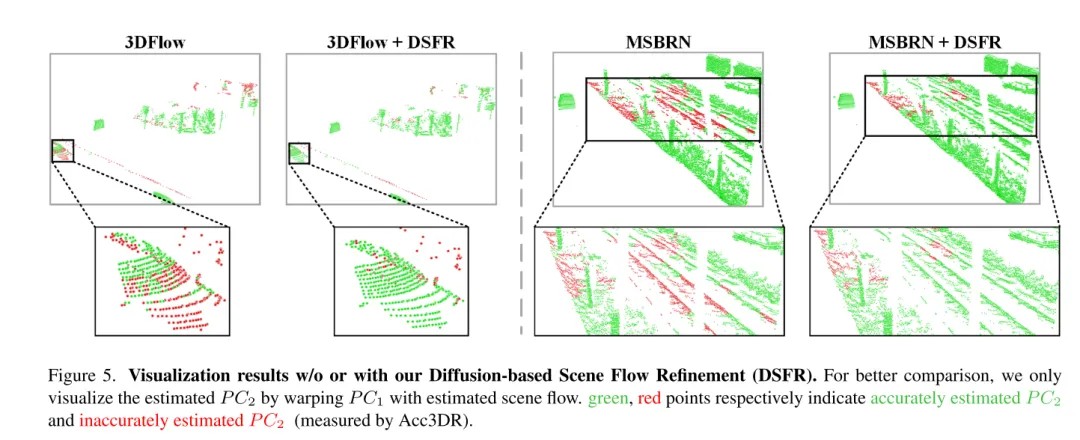

图 5. 未使用或使用基于扩散的场景流细化 (DSFR) 的可视化结果。

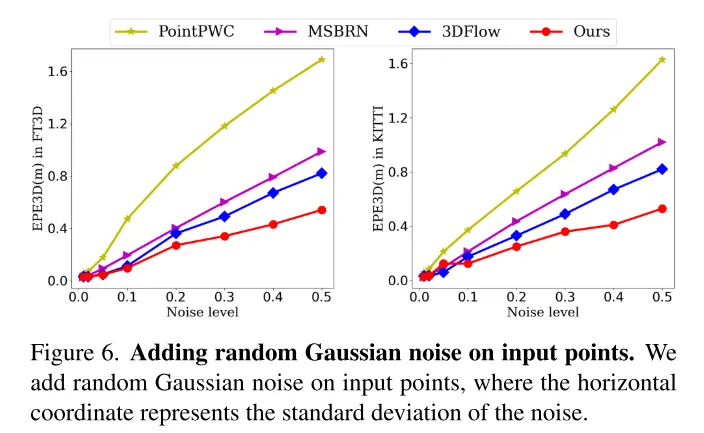

图6。在输入点上添加随机高斯噪声。

图7。不确定性在训练过程中的作用。本文分别在不同的训练阶段(第10轮和第100轮)可视化了不确定性区间。

总结:

本文创新性地提出了一个基于扩散的场景流细化网络,该网络能够感知估计的不确定性。本文采用多尺度扩散细化来生成细粒度的密集流残差。为了提高估计的鲁棒性,本文还引入了与场景流一起联合生成的逐点不确定性。广泛的实验表明了本文的 DifFlow3D 的优越性和泛化能力。值得注意的是,本文的基于扩散的细化可以作为即插即用模块应用于以往的工作,并为未来的研究提供新的启示。

引用:

Liu J, Wang G, Ye W, et al. DifFlow3D: Toward Robust Uncertainty-Aware Scene Flow Estimation with Diffusion Model[J]. arXiv preprint arXiv:2311.17456, 2023.

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

- 618狂欢,华为Mate X3成为折叠屏手机市场亮点

- 6月15日消息,一年一度的618大促正在全国范围内火热展开。这个时候,消费者们都迫不及待地投入到疯狂的购物狂欢中。其中,折叠屏手机成为众多消费者关注的焦点。据小编了解,华为的最新折叠屏旗舰MateX3成为很多消费者的首选。华为MateX3作为华为今年3月发布的折叠屏旗舰手机,采用了华为自研的材料和专利技术,受到了广大消费者的赞誉。机身轻薄,重量仅为239克,折叠时厚度仅11.08毫米,展开时薄至5.3毫米,比前代产品厚度减薄了一半以上。这款手机拿在手上和其他直屏旗舰机几乎没有区别,使用起来非常轻松,受到用

- 5分钟前 0

-

正版软件

正版软件

- 宏碁进军显卡市场,推出Predator BiFrost品牌显卡

- 7月15日消息,宏碁(Acer)计划进一步扩大其产品线,正式进军显卡市场。根据最新消息,宏碁在2022年推出了全新的PredatorBiFrost品牌,其中包括英特尔A770、A750和AMDRX7600等四款显卡。据宏碁官网显示,这三款PredatorBiFrost品牌显卡在设计上相似,而旗舰型号A770更是加入了RGB灯效。而A770的售价为11900新台币(约合2749元人民币),A750售价为7990新台币(约合1846元人民币),RX7600售价为8490新台币(约合1961元人民币)。据小编了

- 15分钟前 宏碁 0

-

正版软件

正版软件

- 《功夫熊猫 4》电影豆瓣开分 6.7,成系列最低

- 本站3月25日消息,梦工厂动画《功夫熊猫4》电影内地定档3月22日,目前豆瓣评分已公布,开分只有6.7分(截至本站发文已降至6.6),成为系列四部中评分最低的一部。▲豆瓣页面截图《功夫熊猫》豆瓣评分8.2《功夫熊猫2》豆瓣评分8.1《功夫熊猫3》豆瓣评分7.8《功夫熊猫4》豆瓣评分6.6此外,《功夫熊猫4》在IMDB评分为6.5,同样是系列四部中最低的一部。▲IMDB截图《功夫熊猫4》由《怪物史瑞克4》导演迈克・米切尔执导,讲述神龙大侠阿宝晋升为和平谷的精神领袖,而新反派变色龙变形女巫“魅影妖后”带来前所

- 30分钟前 功夫熊猫 0

-

正版软件

正版软件

- 小米汽车严正声明:SU7官方无额外优惠,警惕非官方欺诈

- 近日备受瞩目的小米SU7汽车因其超越的性价比和先进的科技配置,在市场上引起了热烈反响。然而,这也引来了一些不能分子的关注。他们在社交平台上声称可以提供购车优惠,并试图进行诈骗活动。虽然市场上的竞争激烈,但消费者应保持警惕,不要因为便宜而上当受骗。建议大家选择正规的渠道购车,并在试图参加抢购活动时,寻求可靠渠道的支持。对于这一现象,小米汽车官方发布严正声明,明确表示目前官方渠道并未提供任何额外的购车优惠。小米汽车提醒广大消费者,若遇到非官方渠道宣传提供额外优惠的情况,务必保持警惕,仔细甄别,以免遭受财产损失

- 50分钟前 小米 0

-

正版软件

正版软件

- 腾讯《元梦之星》回应被网易《蛋仔派对》地图作者起诉:已将相关地图全量下架

- 本站3月28日消息,网易《蛋仔仔派对》知名UGC地图《因蓝》的创作者@仟中酒日前在抖音发布视频称,因为创作的地图在《元梦之星》中被长期、多次地抄袭,已经向腾讯发起诉讼,案件已被受理,将于5月开庭。今日下午,腾讯《元梦之星》游戏官方微博发布《关于地图创作原创保护的声明》,在收到《因蓝》地图作者的维权投诉后,经人工审核,我们已将被投诉的相关创作地图全量下架,并依据《元梦之星侵权投诉通知指引》中的处理原则,以游戏内邮件通知了被投诉玩家。随后《元梦之星》运营团队更进一步升级了处理政策,禁止所有玩家发布、使用含“因

- 1小时前 02:35 蛋仔派对 元梦之星 腾讯网易 0