登Nature子刊,哈佛医学院发布迄今最大计算病理学基础模型,适用30+临床需求

发布于2024-12-24 阅读(0)

发布于2024-12-24 阅读(0)

扫一扫,手机访问

编辑 | X

基础模型有望为医学领域带来前所未有的进步。

在计算病理学 (CPath) 中,基础模型在提高诊断准确性、预后以及预测治疗反应方面发挥着关键作用。

美国麻省总医院和哈佛医学院联合研究团队最近设计了两个名为UNI和CONCH的CPath基础模型,这是迄今为止规模最大的。这些模型覆盖了30多种临床和诊断需求,包括疾病检测、诊断、器官移植评估和罕见疾病分析。这一研究成果有望为医学领域带来新的突破和进展。

新模型不仅在研究人员测试的临床任务中表现出色,而且在识别新的、罕见的和具有挑战性的疾病方面也显示出了潜力。UNI 和 CONCH 的相关研究成果发表在《Nature Medicine》杂志上。这些成果表明,这两个模型克服了当前模型的局限性,为未来的医疗诊断和治疗带来了新的可能性。这标志着对医学领域的巨大进步,为更准确、更高效地处理各种疾病提供了新的工具和方法。这项研究的成功为医学界带来了希望,未来有

UNI:理解病理学图像的基础模型

对于计算病理学任务来说,对组织图像进行定量评估至关重要,这需要对全玻片图像(WSI)中的组织病理学结构进行客观描述。WSI 具有高分辨率和形态特征的多样性,这给大规模数据标注的高性能应用带来了挑战。

为了解决这一挑战,目前的研究已经提出了利用自然图像数据集进行迁移学习,或者通过对公开的组织病理学数据集进行自监督学习,以利用预训练的图像编码器。然而,对于不同类型的组织,在大规模范围内广泛开发和评估这些方法仍然具有挑战性。

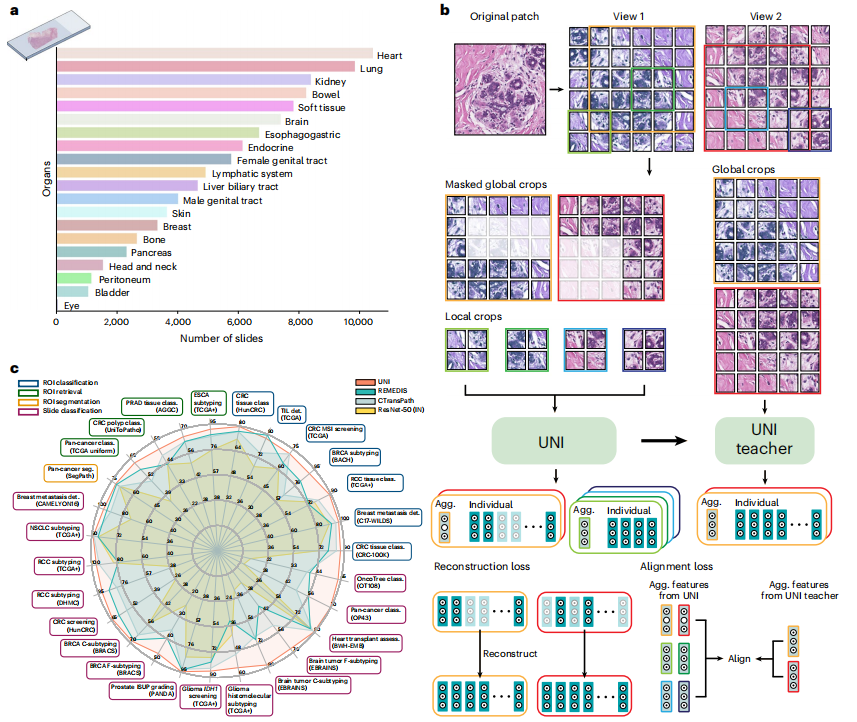

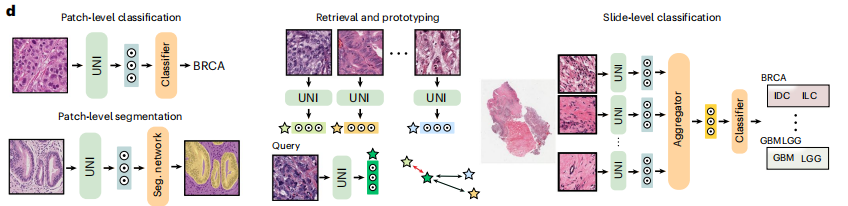

为了提高病理学图像的识别和理解能力,该研究团队开发了一种名为UNI的通用病理学自监督模型。UNI模型作为病理学图像的基础模型,能够识别组织学感兴趣区域中的疾病,并实现十亿像素全幻灯片成像。该模型利用包含超过1亿个组织斑块和超过100,000张WSI的数据库进行训练,具有在解剖病理学领域通用的人工智能应用价值。这一创新有望为病理学领域带来更深入和准确的研究成果,为医学诊断和治疗提供更精确的支持。

图示:UNI 概述。(来源:论文)

该模型在 34 个具有不同诊断难度的代表性 CPath 任务上进行了评估。除了超越以前最先进的模型之外,还展示了 CPath 中的新建模功能,例如与分辨率无关的组织分类,使用少量类别原型的幻灯片分类,以及在 OncoTree 分类系统中对多达 108 种癌症进行分类的疾病亚型概括。

UNI 在预训练数据和下游评估方面在 CPath 中大规模推进无监督表示学习,从而实现数据高效的人工智能模型,该模型可以泛化并转移到解剖病理学中广泛的诊断挑战性任务和临床工作流程。

相关研究以《Towards a general-purpose foundation model for computational pathology》为题,于 2024 年 3 月 19 日发布在《Nature Medicine》上。

开源地址:https://github.com/mahmoodlab/UNI

论文链接:https://www.nature.com/articles/s41591-024-02857-3

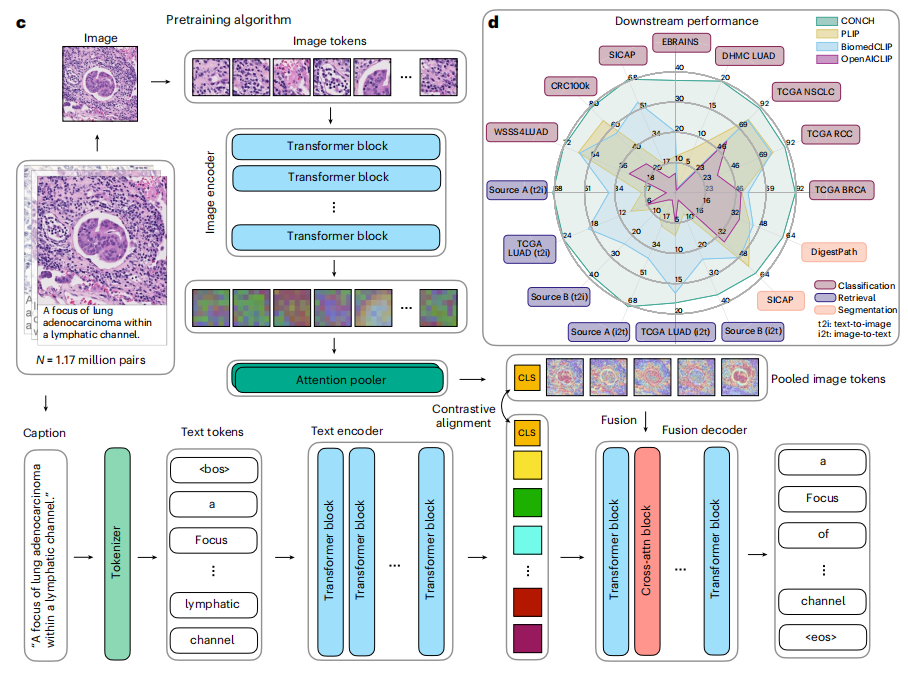

CONCH:计算病理学的视觉语言基础模型

数字病理学的广泛应用和深度学习技术的进步,已经为各类疾病和患者群体中的多种病理任务开发出强大模型提供了可能。

然而,由于医学领域标签稀缺,模型训练通常很困难,并且模型的使用受到训练的特定任务和疾病的限制。此外,大多数组织病理学模型仅利用图像数据,这与人类相互教导和推理组织病理学实体的方式形成鲜明对比。

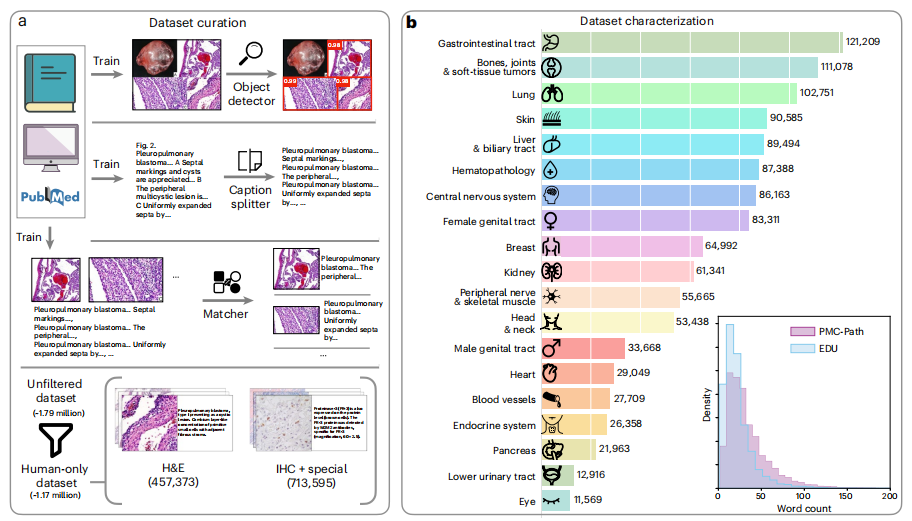

基于此,该研究团队提出了一种视觉语言基础模型 CONCH,CONCH 经过超过 117 万个组织病理学图像-文本对的数据库的训练。

CONCH 在识别罕见疾病、肿瘤分割和理解十亿像素图像等任务方面表现出色。由于 CONCH 接受了文本训练,病理学家可以与模型交互以搜索感兴趣的形态。

图示:数据整理和 CONCH 模型示意图。(来源:论文)

CONCH 根据一套 14 个不同的基准进行评估,可以转移到涉及组织病理学图像、文本的广泛下游任务,在组织病理学图像分类、分割、字幕、文本到图像和图像到文本检索方面实现最先进的性能。

CONCH 代表了组织病理学并发视觉语言预训练系统的重大飞跃,有可能直接促进各种基于机器学习的工作流程,只需要很少或不需要进一步的监督微调。

相关研究以《A visual-language foundation model for computational pathology》为题,于 3 月 19 日发布在《Nature Medicine》上。

开源地址:https://github.com/mahmoodlab/CONCH

论文链接:https://www.nature.com/articles/s41591-024-02856-4

研究团队正在向其他学术团体公开该代码,以用于解决临床相关问题。

麻省总医院病理科计算病理学部的通讯作者 Faisal Mahmood 博士说,「基础模型代表了医学人工智能的新范式,这些模型是 AI 系统,可以适应许多下游、临床相关的任务。我们希望这些研究中提出的概念验证将为此类自监督模型在更大、更多样化的数据集上进行训练奠定基础。」

参考内容:https://medicalxpress.com/news/2024-03-ai-foundation-advance-pathology.html

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

- 商务部部长王文涛会见 SK 海力士首席执行官郭鲁正

- 据商务部官方消息,今天,商务部部长王文涛会见了韩国SK海力士首席执行官郭鲁正。双方就SK海力士在中国的发展以及中韩半导体产业链供应链合作等问题进行了交流。王文涛表示,中国正以高质量发展全面推进中国式现代化,推进高水平对外开放,将释放更多开放发展红利。当前,中国经济持续回升向好,加快发展新质生产力,数字经济发展迅速,电子信息产品消费市场潜力巨大,希望SK海力士继续加大在华投资,深耕中国,共享中国高质量发展带来的增长机遇。郭鲁正表示,中国已成为SK海力士最重要的生产基地和销售市场之一,将继续扎根中国,不断推进

- 8分钟前 海力士 商务部 0

-

正版软件

正版软件

- 宝马纯电动车型在中国市场大获成功 销量增长超过200%

- 7月10日消息,宝马近日在长沙成立了一家新的汽车销售公司,注册资本达1800万元人民币。根据天眼查App显示,最近成立了长沙宝创汽车销售服务有限公司。该公司的法定代表人是姚美洁,注册资本为1800万人民币。该公司的经营范围涵盖新能源汽车整车销售、充电桩销售、二手车经纪、保险兼业代理业务等。股东信息显示,该公司为宝马汽车(香港)有限公司全资持股。据小编了解,作为一家知名的豪华汽车品牌,宝马凭借其强大的性能、可靠的品质和品牌溢价,一直在国内高端汽车市场占据重要份额。最近,宝马集团公布了2023年上半年的交付数

- 13分钟前 0

-

正版软件

正版软件

- OPPO、一加、realme或将全面采用超声波屏下指纹技术

- 近日,博主@数码闲聊站爆料称,OPPO、一加、realme等手机品牌正在测试超声波下指纹技术,该技术有望取代目前的超薄光学指纹方案。这一举措旨在提升指纹识别的精度和速度,并且更加安全可靠。据悉,该技术已经在超薄光学指纹方案的基础上进行了优化,同时还采用了超曲面指纹识别技术,让用户的使用体验数据小编了解,超声波指纹和光学指纹是当前主流的解锁技术。尽管两者在技术上都已经相当成熟,但超声波指纹因其易用性和安全性更高而受到部分厂商的青睐。然而,由于成本等因素,并非所有手机厂商都愿意采用这项技术。目前市场上,iQO

- 28分钟前 OPPO 一加 0

-

正版软件

正版软件

- 中国联通与中国石化签约,在 AI、加油站油品与非油品业务服务等方面合作

- 据报道,中国联通和中国石化在北京签署了战略合作协议。中国联通董事长陈忠岳和中国石化董事长马永生出席签约仪式并见证了协议的签署。该协议是中石化副总经理林宝俊与中国石化副总经理李永林代表双方签署的。这份协议旨在加强两家公司的合作,包括在5G等新技术领域深度合作。据悉,中国联通和中国石化的副总经理代表双方签署了协议。此次签约符合中国联通和中国石化的战略合作方向,将进一步扩大两个行业之间的合作领域,推动根据协议内容,双方将在5G+工业互联网、数字化转型、人工智能、基础通信服务、新型基础设施建设、金融科技服务、采购

- 43分钟前 中国联通 中国石化 0

-

正版软件

正版软件

- 起亚全新K4海外亮相,独特设计引领潮流

- 近日,起亚汽车发布了全新紧凑型轿车K4,这款车将在海外市场取代现款Forte,成为起亚品牌产品线的重要组成部分。尽管K4这个名字在国内曾经使用过,但停产的2017年版本与此次发布的全新K4并没有直接联系。这次发布的K4将作为起亚品牌发展战略的一部分,展示出公司对新产品推出的决心和努力。起亚希望通过这款车开拓新市场,提升品牌影响力,为消费者带来更多选择和体验。全新K4吸收了起亚最新的设计灵感,以一种前所未有的风格展现在大众面前。它的前脸设计充满力量,LED日间行车灯与黑色中网完美融合,展现出一种不容忽视的攻

- 58分钟前 起亚汽车 0

最新发布

-

1

1

- 阿里追捧的中台,“热度”退了?

- 1841天前

-

2

2

- Overture设置踏板标记的方法

- 1678天前

-

3

3

- 思杰马克丁取得CleanMyMac中国区独家发行授权

- 1668天前

-

4

4

- IBM:20万台Mac让公司职工在工作中更快乐 更多产

- 1866天前

-

5

5

- 报道称微软一直在悄然游说反对“维修权”立法!

- 1832天前

-

6

6

- 美国怀疑华为窃取商业机密 华为:身正不怕影子斜

- 1828天前

-

7

7

- 三星被曝正与联发科接洽 A系列手机有望搭载其5G芯片

- 1843天前

-

8

8

- 环球墨非完成千万级融资 联合企业集团投资

- 1864天前

-

9

9

相关推荐

热门关注

-

- Xshell 6 简体中文

- ¥899.00-¥1149.00

-

- DaVinci Resolve Studio 16 简体中文

- ¥2550.00-¥2550.00

-

- Camtasia 2019 简体中文

- ¥689.00-¥689.00

-

- Luminar 3 简体中文

- ¥288.00-¥288.00

-

- Apowersoft 录屏王 简体中文

- ¥129.00-¥339.00