解析Java爬虫的定义与功能

发布于2024-10-27 阅读(0)

发布于2024-10-27 阅读(0)

扫一扫,手机访问

探究Java爬虫的定义与功能,需要具体代码示例

导语:随着互联网的发展,爬虫成为了从互联网上获取数据的重要工具之一。本文将重点探究Java爬虫的定义与功能,并提供一些具体的代码示例。

一、Java爬虫的定义

Java爬虫是一种程序,它可以模拟人的行为,自动在互联网上浏览网页,并按照一定的规则提取感兴趣的数据。Java爬虫一般由两部分组成,即爬取器和解析器。爬取器负责发起HTTP请求,获取网页的源代码;解析器则负责解析网页源代码,从中提取出需要的数据。

二、Java爬虫的功能

- 数据采集:Java爬虫可以主动地从互联网上抓取网页数据,并存储到本地或云端数据库中。这样,我们就能够快速且高效地获取大量需要的数据,如新闻、商品信息、用户评论等。

- 数据分析:Java爬虫获取到的数据可以进行进一步的分析,如文本分析、情感分析、关联分析等。通过分析数据,我们可以得到有价值的信息,从而支持决策和推断。

- 数据挖掘:Java爬虫可以根据需求,自动地在互联网上采集大量的数据,并通过算法和模型进行挖掘,以发现新的规律和潜在的商业机会。

- 竞争对手分析:通过Java爬虫,我们可以轻松地获取到竞争对手的网站数据,如价格、销量、产品信息等。这样一来,我们可以对竞争对手进行详细的分析,并制定相应的策略。

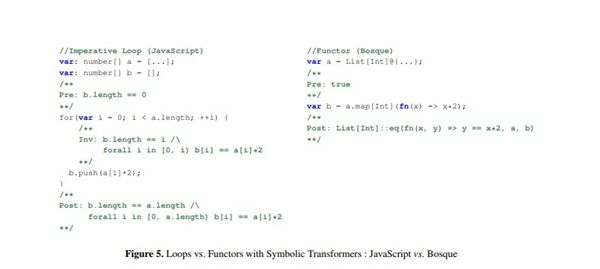

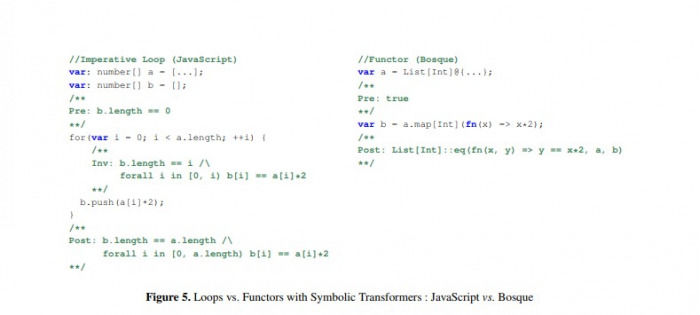

三、实例代码示例

下面是一个简单的Java爬虫示例,用于抓取某个网站上的新闻标题和链接:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

public class WebCrawler {

public static void main(String[] args) {

String url = "http://www.example.com/news"; // 目标网站的URL

try {

Document doc = Jsoup.connect(url).get(); // 使用Jsoup发起HTTP请求,获取网页源代码

Elements elements = doc.select("a"); // 使用Jsoup解析网页源代码,获取所有的a标签

for (Element element : elements) {

String title = element.text(); // 获取a标签的文本内容,即新闻标题

String link = element.attr("href"); // 获取a标签的href属性,即新闻链接

System.out.println("标题:" + title);

System.out.println("链接:" + link);

}

} catch (IOException e) {

e.printStackTrace();

}

}

}以上代码使用了Jsoup这个Java库,它是一款十分强大和灵活的HTML解析工具。通过连接目标网站并获取其网页源代码,我们可以使用CSS选择器来提取文本内容和链接。

总结:Java爬虫是一种非常实用的工具,可以用于数据采集、数据分析、数据挖掘和竞争对手分析等多种场景。在实际应用中,我们根据需求,可以编写相应的爬虫程序来满足特定的数据获取和分析需求。使用Java开发爬虫,我们只需要选择合适的工具和框架,就能够快速构建出功能强大的爬虫系统。通过不断地学习和实践,我们可以进一步提升爬虫技术的能力,为自己和企业带来更大的价值。

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

- 解决eclipse乱码问题的快速方法

- 如何快速解决Eclipse出现的乱码Eclipse是一个使用广泛的集成开发环境(IDE),但有时候在使用过程中会遇到中文乱码的问题。本文将介绍如何快速解决Eclipse中文乱码问题,并提供具体的代码示例。修改Eclipse编码设置在Eclipse的安装目录下找到eclipse.ini文件,使用文本编辑器打开。找到以下代码行:-Dfile.encoding=U

- 11分钟前 eclipse 解决 乱码 0

-

正版软件

- Tomcat WAR包部署的最佳做法

- Tomcat部署WAR包的最佳实践,需要具体代码示例Tomcat是一个被广泛使用的开源JavaServlet容器,用于部署和管理JavaWeb应用程序。其中,WAR(WebApplicationArchive)包是一种常见的Web应用程序打包格式,扩展名为.war。在本文中,我们将探讨Tomcat部署WAR包的最佳实践,并提供相关的代码示例。准备工作

- 26分钟前 tomcat 部署 war包 0

-

正版软件

- Go语言中各种运算符的优先级排序详解

- 深入解析Go语言中各种运算符的优先级排序方法在Go语言中,运算符的优先级决定了表达式中运算符的计算顺序。正确理解运算符的优先级是编写高效代码的关键之一。本文将深入解析Go语言中各种运算符的优先级排序方法,并提供具体的代码示例。一、算术运算符的优先级在Go语言中,算术运算符的优先级从高到低为:一元运算符:+,-乘法运算符:*,/,%加法运算符:+,-比

- 41分钟前 运算符优先级 Go语言运算符 优先级排序方法 0

-

正版软件

- 简单指南:安装和配置Ubuntu VNC

- 轻松上手:UbuntuVNC安装和配置指南导语:Ubuntu是一款功能强大且广受欢迎的操作系统,VNC则是一种远程桌面协议,可以使用户通过网络控制远程计算机。本文将带你详细了解Ubuntu系统中VNC的安装和配置过程,包括具体代码示例。第一步:安装VNCServer打开终端(Terminal),输入以下命令以安装VNCServer:sudoapt-g

- 56分钟前 Ubuntu vnc 安装配置 0

-

正版软件

- 深入研究Java开发的核心技术,成就优秀的开发人员

- 深入探索Java开发的核心技术,成就卓越的开发者,需要具体代码示例近年来,Java作为一种广泛应用于企业级开发的编程语言,已经成为了开发者们的首选之一。Java强大的跨平台性、面向对象的设计思想、丰富的类库和成熟稳定的开发环境,使其在大型项目开发中扮演着重要的角色。而要成为一名卓越的Java开发者,不仅需要掌握其语法和基础知识,还需要深入了解其核心技术。本文

- 1小时前 16:05 深入探索 Java核心技术 开发者成就 0

最新发布

-

1

1

-

2

2

-

3

- WebSocket协议的优势与劣势分析

- 379天前

-

4

- Vue组件中如何处理图片预览和缩放问题

- 378天前

-

5

5

-

6

- java动态代理实例代码分析

- 549天前

-

7

7

-

8

8

- Python实战教程:批量转换多种音乐格式

- 549天前

-

9

9

- java io文件操作删除文件或文件夹的方法

- 546天前

相关推荐

热门关注

-

- Xshell 6 简体中文

- ¥899.00-¥1149.00

-

- DaVinci Resolve Studio 16 简体中文

- ¥2550.00-¥2550.00

-

- Camtasia 2019 简体中文

- ¥689.00-¥689.00

-

- Luminar 3 简体中文

- ¥288.00-¥288.00

-

- Apowersoft 录屏王 简体中文

- ¥129.00-¥339.00