学习如何使用Java进行网络爬虫:必备技术与工具的指南

发布于2024-11-03 阅读(0)

发布于2024-11-03 阅读(0)

扫一扫,手机访问

Java爬虫入门指南:必备的技术与工具,需要具体代码示例

一、导言

随着互联网的快速发展,人们在网络上获取信息的需求越来越大。而爬虫作为一种自动化获取网络信息的技术,正变得越来越重要。Java作为一种功能强大的编程语言,也在爬虫领域中有着广泛的应用。本篇文章将介绍Java爬虫的必备技术与工具,并提供具体的代码示例,帮助读者入门。

二、必备的技术

- HTTP请求

爬虫的首要任务是模拟浏览器发送HTTP请求,获取网页内容。Java提供了多种HTTP请求库,常用的有HttpClient和URLConnection。下面是使用HttpClient发送GET请求的示例代码:

import org.apache.http.HttpEntity;

import org.apache.http.HttpResponse;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.HttpClientBuilder;

import org.apache.http.util.EntityUtils;

public class HttpUtils {

public static String sendGetRequest(String url) {

HttpClient httpClient = HttpClientBuilder.create().build();

HttpGet httpGet = new HttpGet(url);

try {

HttpResponse response = httpClient.execute(httpGet);

HttpEntity entity = response.getEntity();

return EntityUtils.toString(entity);

} catch (IOException e) {

e.printStackTrace();

return null;

}

}

}- HTML解析

获取到网页内容后,需要从HTML中提取出所需的信息。Java有多种HTML解析库可供选择,其中最常用的是Jsoup。下面是使用Jsoup解析HTML的示例代码:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class HtmlParser {

public static void parseHtml(String html) {

Document doc = Jsoup.parse(html);

Elements links = doc.select("a[href]"); // 解析出所有的链接

for (Element link : links) {

System.out.println(link.attr("href"));

}

}

}- 数据存储

爬虫获取到的数据需要进行存储,Java提供了多种数据库操作库,如JDBC、Hibernate和MyBatis等。此外,还可以使用文件存储数据,常见的文件格式有CSV和JSON。下面是使用CSV格式存储数据的示例代码:

import java.io.FileWriter;

import java.io.IOException;

import java.util.List;

public class CsvWriter {

public static void writeCsv(List<String[]> data, String filePath) {

try (FileWriter writer = new FileWriter(filePath)) {

for (String[] row : data) {

writer.write(String.join(",", row));

writer.write("

");

}

} catch (IOException e) {

e.printStackTrace();

}

}

}三、必备的工具

- 开发环境

编写和运行Java爬虫程序需要一个适合的开发环境。推荐使用Eclipse或Intellij IDEA等集成开发环境(IDE),它们提供了丰富的编辑器和调试器功能,可以大大提高开发效率。

- 版本控制工具

使用版本控制工具能够方便地管理代码并与团队成员协作。Git是目前最流行的版本控制工具,可以轻松地创建和合并代码分支,方便多人开发。

- 日志工具

在开发爬虫过程中,很可能遇到一些问题,如页面解析失败或者数据存储异常。使用日志工具可以帮助定位问题并进行调试。Java中最常用的日志工具是Log4j和Logback。

四、代码示例

下面是一个完整的Java爬虫示例,它使用HttpClient发送HTTP请求,使用Jsoup解析HTML,并将解析结果保存为CSV文件:

import org.apache.http.HttpEntity;

import org.apache.http.HttpResponse;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.HttpClientBuilder;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.FileWriter;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class WebCrawler {

public static void main(String[] args) {

String url = "http://example.com";

String html = HttpUtils.sendGetRequest(url);

HtmlParser.parseHtml(html);

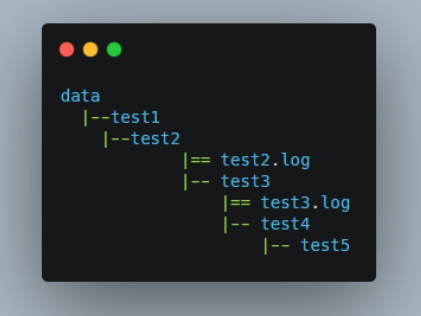

CsvWriter.writeCsv(data, "data.csv");

}

}以上示例代码仅作为入门指南,实际应用中可能需要根据情况进行适当修改和扩展。希望读者通过本文的介绍,能够初步了解Java爬虫的基本技术和工具,并在实际项目中得到应用。

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

- 实现Grav框架的平滑升级的方法是什么?

- Grav框架是一款流行的PHP静态网站生成器,能够轻松地生成高性能、可扩展的网站。一个好的网站需要不断地更新和升级,以保持其稳定性和性能。但是,升级可能会产生潜在的风险,可能会导致不良后果,因此,如何在Grav框架中实现平滑升级是非常重要的。一、备份你的网站在升级之前,备份你的整个网站是非常重要的。如果出现问题,备份将可以快速恢复您的网站至原始状态。您可以选

- 10分钟前 编程 Grav 平滑升级 0

-

正版软件

- 优化Scrapy爬虫:提高效率,减少重复URL的抓取

- Scrapy是一个功能强大的Python爬虫框架,可以用于从互联网上获取大量的数据。但是,在进行Scrapy开发时,经常会遇到重复URL的爬取问题,这会浪费大量的时间和资源,影响效率。本文将介绍一些Scrapy优化技巧,以减少重复URL的爬取,提高Scrapy爬虫的效率。一、使用start_urls和allowed_domains属性在Scrapy爬虫中,可

- 25分钟前 优化 URL Scrapy 0

-

正版软件

- Java 应用性能监测与优化技术

- 随着业务系统规模的不断增大,应用的性能问题越来越成为程序员和系统管理员们的头疼问题。而Java作为世界最流行的编程语言之一,在应用性能监控和性能优化方面也有丰富的技术和工具。本文将介绍Java中常用的应用性能监控和性能优化技术,并分析其优缺点。一、应用性能监控技术JMX(JavaManagementExtensions)JMX是Java平台

- 40分钟前 Java 性能优化 性能监控 0

-

正版软件

- 个人信息修改功能在PHP开发的二手回收网站中的实现

- PHP开发的二手回收网站实现个人信息修改功能随着二手回收的需求逐渐增加,二手回收网站成为了一个十分热门的领域。而其中,个人信息的修改是一个非常重要的功能,能够让用户随时随地更新自己的个人信息。本文将介绍如何使用PHP开发一个二手回收网站,并实现个人信息修改的功能。首先,我们需要创建一个数据库,用于存储用户的个人信息。我们可以使用MySQL数据库,并创建一个名

- 55分钟前 PHP开发 二手回收 个人信息修改 0

-

正版软件

- 提升MySQL数据查询统计的技巧

- MySQL是一种非常常见的关系型数据库,其广泛应用于各种企业应用中。在这些应用中,对数据的查询和统计是至关重要的工作。在本文中,我们将会介绍一些MySQL中的数据查询和统计技巧,帮助读者更好地处理数据。使用索引索引是一种特殊的数据结构,它可以提高查询效率。在MySQL中,我们可以通过一些关键字(如:CREATEINDEX)来创建索引。在创建索引时,我们可以

- 1小时前 10:05 数据查询 数据统计 MySQL查询技巧 0

最新发布

-

1

1

-

2

2

-

3

- Vue组件中如何处理图片预览和缩放问题

- 393天前

-

4

- WebSocket协议的优势与劣势分析

- 394天前

-

5

5

-

6

- java动态代理实例代码分析

- 564天前

-

7

7

-

8

8

- Python实战教程:批量转换多种音乐格式

- 564天前

-

9

9

- java io文件操作删除文件或文件夹的方法

- 561天前

相关推荐

热门关注

-

- Xshell 6 简体中文

- ¥899.00-¥1149.00

-

- DaVinci Resolve Studio 16 简体中文

- ¥2550.00-¥2550.00

-

- Camtasia 2019 简体中文

- ¥689.00-¥689.00

-

- Luminar 3 简体中文

- ¥288.00-¥288.00

-

- Apowersoft 录屏王 简体中文

- ¥129.00-¥339.00