中国科学院、华为等公司推出VMamba,与Swin时刻的视觉Mamba模型相媲美

发布于2024-11-21 阅读(0)

发布于2024-11-21 阅读(0)

扫一扫,手机访问

Transformer在大模型领域的地位无可撼动。然而,随着模型规模的扩展和序列长度的增加,传统的Transformer架构的局限性开始凸显。幸运的是,Mamba的问世正在迅速改变这一现状。它出色的性能立即引起了AI界的轰动。Mamba的出现为大规模模型的训练和序列处理带来了巨大的突破。它的优势在AI界迅速蔓延,为未来的研究和应用带来了巨大的希望。

上周四, Vision Mamba(Vim)的提出已经展现了它成为视觉基础模型的下一代骨干的巨大潜力。仅隔一天,中国科学院、华为、鹏城实验室的研究人员提出了 VMamba:一种具有全局感受野、线性复杂度的视觉 Mamba 模型。这项工作标志着视觉 Mamba 模型 Swin 时刻的来临。

- 论文标题:VMamba: Visual State Space Model

- 论文地址: https://arxiv.org/abs/2401.10166

- 代码地址: https://github.com/MzeroMiko/VMamba

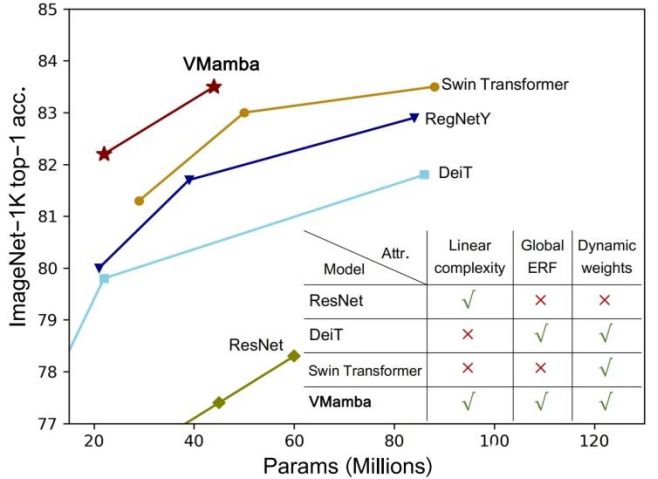

CNN 和视觉 Transformer(ViT)是当前最主流的两类基础视觉模型。尽管 CNN 具有线性复杂度,ViT 具有更为强大的数据拟合能力,然而代价是计算复杂较高。研究者认为 ViT 之所以拟合能力强,是因为其具有全局感受野和动态权重。受 Mamba 模型的启发,研究者设计出一种在线性复杂度下同时具有这两种优秀性质的模型,即 Visual State Space Model(VMamba)。大量的实验证明,VMamba 在各种视觉任务中表现卓越。如下图所示,VMamba-S 在 ImageNet-1K 上达到 83.5% 的正确率,比 Vim-S 高 3.2%,比 Swin-S 高 0.5%。

方法介绍

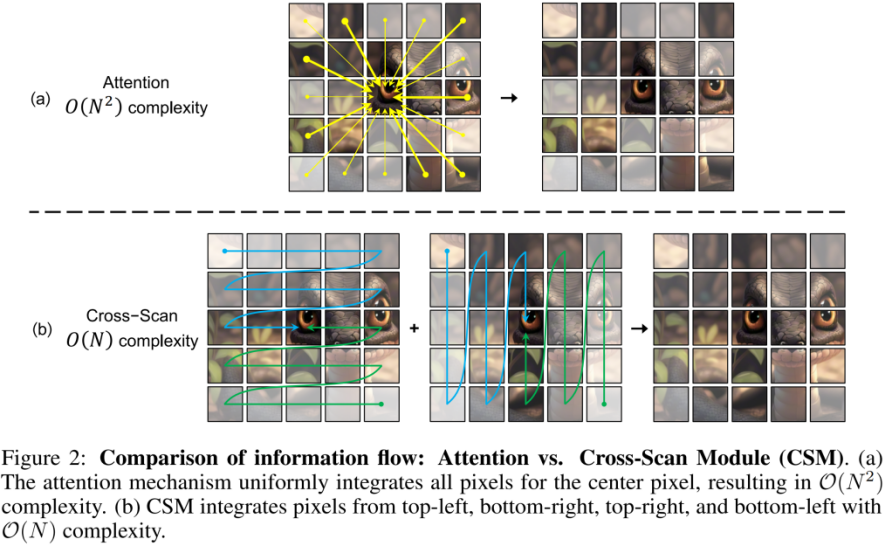

VMamba 的成功关键在于采用了 S6 模型,这个模型最初是为了解决自然语言处理(NLP)任务而设计的。与 ViT 的注意力机制不同,S6 模型通过将 1D 向量中的每个元素与之前的扫描信息进行交互,有效地将二次复杂度降低为线性。这种交互方式使得 VMamba 在处理大规模数据时更加高效。因此,S6 模型的引入为 VMamba 的成功打下了坚实的基础。

然而,由于视觉信号(如图像)不像文本序列那样具有天然的有序性,因此无法在视觉信号上简单地对 S6 中的数据扫描方法进行直接应用。为此研究者设计了 Cross-Scan 扫描机制。Cross-Scan 模块(CSM)采用四向扫描策略,即从特征图的四个角同时扫描(见上图)。该策略确保特征中的每个元素都以不同方向从所有其他位置整合信息,从而形成全局感受野,又不增加线性计算复杂度。

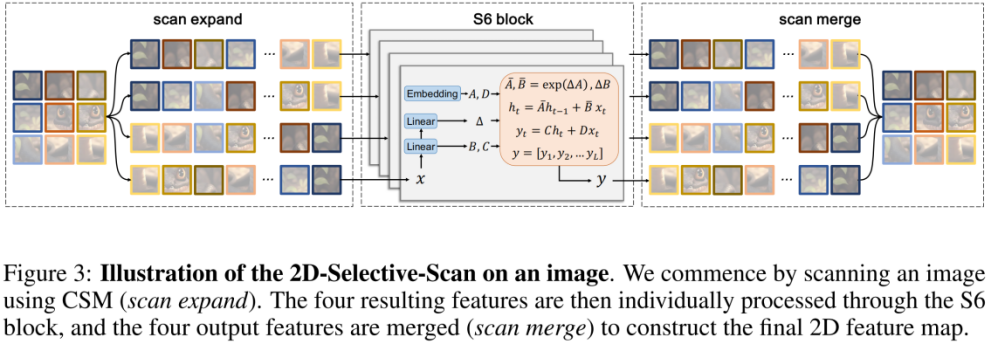

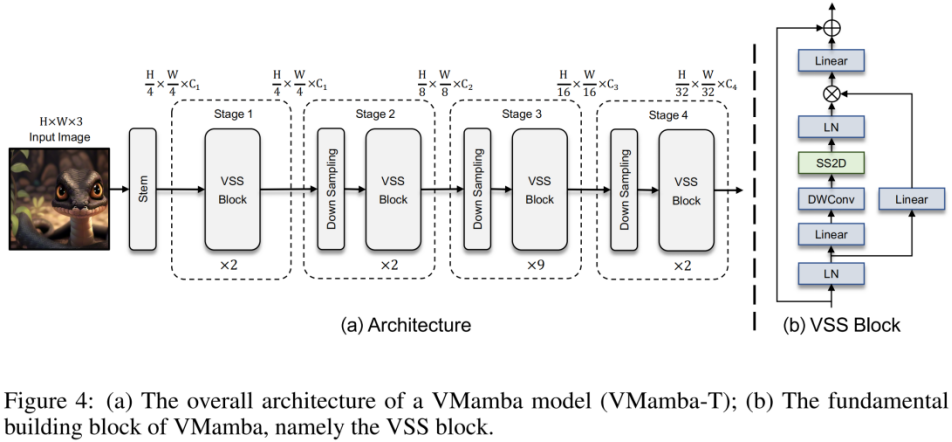

在 CSM 的基础上,作者设计了 2D-selective-scan(SS2D)模块。如上图所示,SS2D 包含了三个步骤:

- scan expand 将一个 2D 特征沿 4 个不同方向(左上、右下、左下、右上)展平为 1D 向量。

- S6 block 独立地将上步得到的 4 个 1D 向量送入 S6 操作。

- scan merge 将得到的 4 个 1D 向量融合为一个 2D 特征输出。

上图为本文提出的 VMamba 结构图。VMamba 的整体框架与主流的视觉模型类似,其主要区别在于基本模块(VSS block)中采用的算子不同。VSS block 采用了上述介绍的 2D-selective-scan 操作,即 SS2D。SS2D 保证了 VMamba 在线性复杂度的代价下实现全局感受野。

实验结果

ImageNet 分类

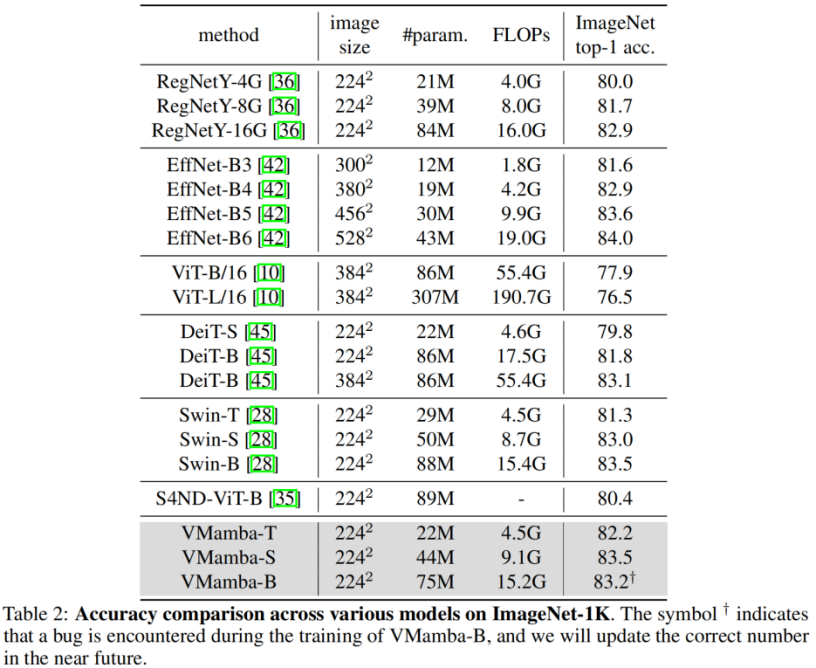

通过对比实验结果不难看出,在相似的参数量和 FLOPs 下:

- VMamba-T 取得了 82.2% 的性能,超过 RegNetY-4G 达 2.2%、DeiT-S 达 2.4%、Swin-T 达 0.9%。

- VMamba-S 取得了 83.5% 的性能,超过 RegNetY-8G 达 1.8%,Swin-S 达 0.5%。

- VMamba-B 取得了 83.2% 的性能(有 bug,正确结果将尽快在 Github 页面更新),比 RegNetY 高 0.3%。

这些结果远高于 Vision Mamba (Vim) 模型,充分验证了 VMamba 的潜力。

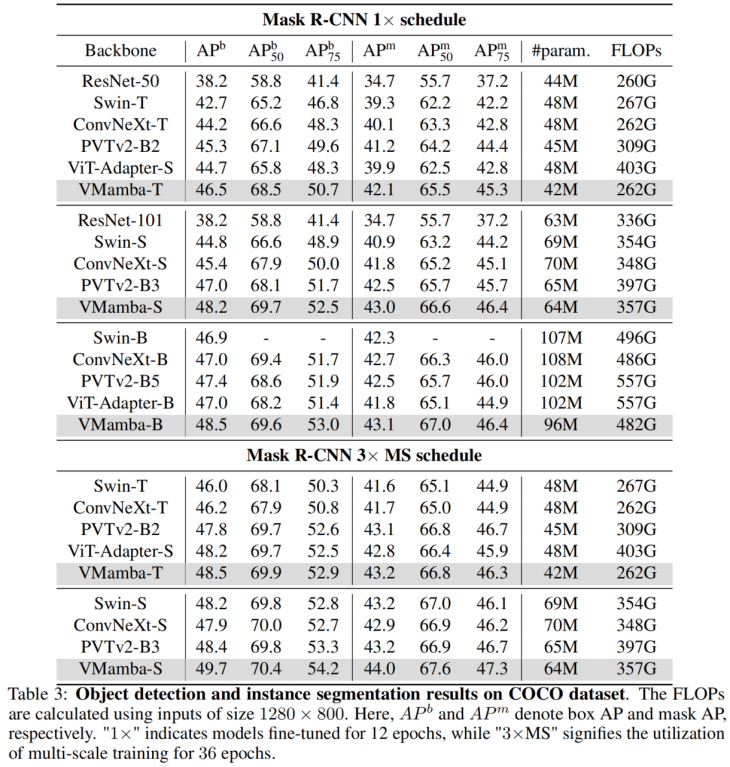

COCO 目标检测

在 COOCO 数据集上,VMamba 也保持卓越性能:在 fine-tune 12 epochs 的情况下,VMamba-T/S/B 分别达到 46.5%/48.2%/48.5% mAP,超过了 Swin-T/S/B 达 3.8%/3.6%/1.6% mAP,超过 ConvNeXt-T/S/B 达 2.3%/2.8%/1.5% mAP。这些结果验证了 VMamba 在视觉下游实验中完全 work,展示出了能平替主流基础视觉模型的潜力。

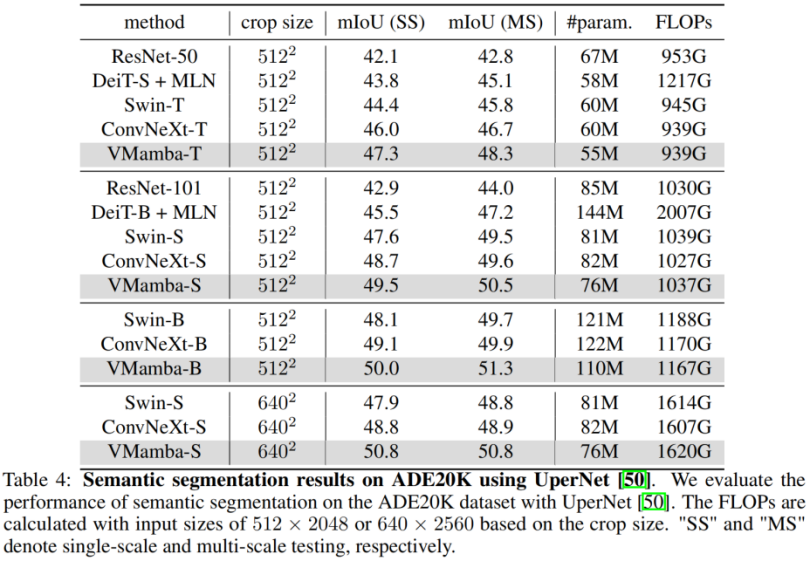

ADE20K 语义分割

在 ADE20K 上,VMamba 也表现出卓越性能。VMamba-T 模型在 512 × 512 分辨率下实现 47.3% 的 mIoU,这个分数超越了所有竞争对手,包括 ResNet,DeiT,Swin 和 ConvNeXt。这种优势在 VMamba-S/B 模型下依然能够保持。

分析实验

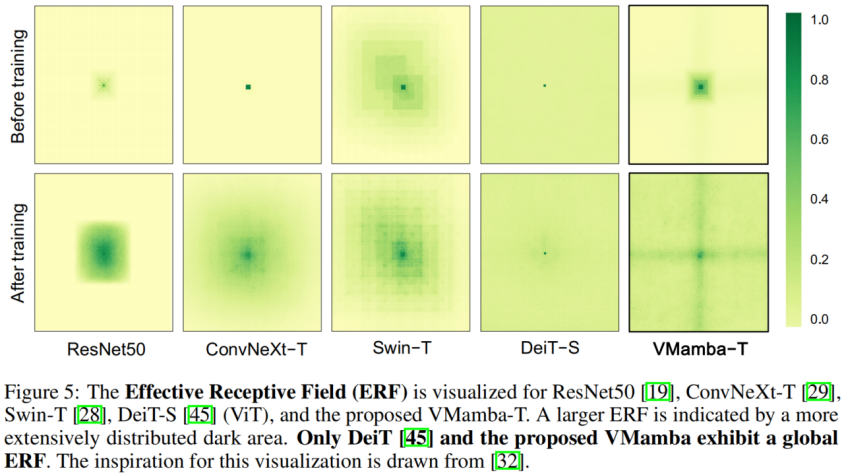

有效感受野

VMamba 具有全局的有效感受野,其他模型中只有 DeiT 具有这个特性。但是值得注意的是,DeiT 的代价是平方级的复杂度,而 VMamaba 是线性复杂度。

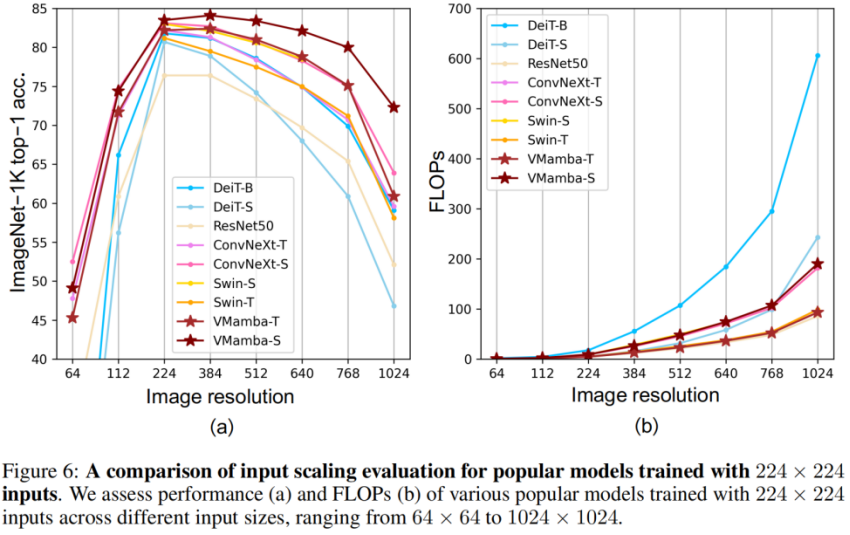

输入尺度缩放

- 上图(a)显示,VMamba 在不同输入图像尺寸下展现出最稳定的性能(不微调)。有意思的是,随着输入尺寸从 224 × 224 增加到 384 × 384,只有 VMamba 表现出性能明显上升的趋势(VMamba-S 从 83.5% 上升到 84.0%),突显了其对输入图像大小变化的稳健性。

- 上图(b)显示,VMamba 系列模型随着输入变大,复杂性呈线性增长,这与 CNN 模型是一致的。

最后,让我们期待更多基于 Mamba 的视觉模型被提出,并列于 CNNs 和 ViTs,为基础视觉模型提供第三种选择。

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

- 应用于算法的基于Attention机制

- Attention机制是一种关键的序列数据处理算法,其主要目标是为序列中的每个元素分配权重,以便在计算输出时考虑它们的相对重要性。这种机制在自然语言处理、图像处理和其他领域都得到了广泛应用。接下来,我将简要介绍几种基于Attention机制的算法及其应用。1.Seq2Seq模型Seq2Seq模型是一种常用的机器翻译模型,使用encoder-decoder架构实现源语言句子到目标语言句子的转换。在该模型中,encoder将源语言句子编码为一个向量,而decoder则利用该向量生成目标语言句子。为了指导dec

- 13分钟前 机器学习 图像处理 0

-

正版软件

正版软件

- 字节跳动员工薪酬调整,间接涨幅达20%!网友赞叹:典范行业标杆!

- 18日晚间,字节跳动以全员邮件方式宣布了一件大事。信中内容一出:总包不变,月薪上涨20%,期权变现加快!网友惊呼:字节要强制涨薪!邮件通知:为提升管理效率,决定对年终奖月数大于3的薪酬方案进行微调。调整如下:目标年终奖月数统一调整为3个月。感谢您的理解和支持。声明:本次调整不影响2023全年绩效评估,并且薪酬结构预计在2023全年绩效评估项目结束后的3月底完成调整,生效日期为2024年1月1日。1~3月月薪差额将在调薪差额发放日一同发放。1、字节绩效大调整经过更新,绩效和激励政策变得更具吸引力。变化主要包

- 18分钟前 互联网 字节跳动 薪资 0

-

正版软件

正版软件

- 抢先解锁小米新机!Redmi K70至尊版豪华配置全面剖析

- 1月22日消息,近日数码圈内热议的焦点集中在小米即将推出的两款新机型——小米14Ultra和RedmiK70至尊版。其中,备受期待的K70至尊版将成为K70系列的压轴之作。根据数码闲聊站透露的消息,一款备受瞩目的RedmiK70至尊版的详细配置参数已经浮出水面。根据各项数据来看,该机很可能会比预期提前发布。数码博主表示这一消息令人惊讶,并暗示K70至尊版将比前代K60至尊版更早与消费者见面。这一消息迅速引发了网友的热议。据了解,RedmiK70至尊版是一款中高端机型,搭载了性能强劲的天玑9300处理器。与

- 33分钟前 Redmi 0

-

正版软件

- 北京市电动自行车团体标准修订即将在6月19日生效,增强电池安全规定

- 6月12日消息,根据北京市市场监管局官网发布的消息,北京市电动自行车团体标准《电动自行车用锂离子动力电池组技术规范》已完成修订,并将于6月19日正式生效。这项标准的修订旨在提高电动自行车使用锂电池的安全性和稳定性,以减少因电池问题引发的爆炸、着火等事故风险。新修订的技术标准共新增了19项、补充完善了20项相关技术要求,其中一些是全国首次正式列入标准的。据小编了解,这些新增的要求包括电池组与整车互认协同识别功能,可避免使用者随意更换不适合的电池组,从而解决电池与车辆不兼容的问题。此外,还包括电池(单体)热滥

- 48分钟前 电动自行车 标准修订 电池安全 0

-

正版软件

正版软件

- 特征工程在机器学习中的模型关系与算法

- 特征工程是对原始数据进行处理,提取出对问题有用的特征,以便于机器学习算法训练。在机器学习领域,特征工程是提高模型性能的关键因素之一。通过精心选择和转换特征,可以改善模型的准确率和鲁棒性。好的特征工程可以帮助算法更好地从数据中学习,并发现数据中的隐藏模式和关联性。它可以减少噪声和冗余信息,提高模型的泛化能力,并且有助于应对数据不平衡和缺失值等问题。因此,特征工程的重要性不可忽视,它可以为机器学特征工程的方法包括:特征选择:选择对模型有用的特征,剔除无用的特征,避免维度灾难。特征提取:从原始数据中提取有用的特

- 1小时前 14:25 机器学习 特征工程 0

最新发布

-

1

1

- 阿里追捧的中台,“热度”退了?

- 1808天前

-

2

2

- Overture设置踏板标记的方法

- 1645天前

-

3

3

- 思杰马克丁取得CleanMyMac中国区独家发行授权

- 1635天前

-

4

4

- IBM:20万台Mac让公司职工在工作中更快乐 更多产

- 1833天前

-

5

5

- 报道称微软一直在悄然游说反对“维修权”立法!

- 1799天前

-

6

6

- 美国怀疑华为窃取商业机密 华为:身正不怕影子斜

- 1795天前

-

7

7

- 三星被曝正与联发科接洽 A系列手机有望搭载其5G芯片

- 1810天前

-

8

8

- 环球墨非完成千万级融资 联合企业集团投资

- 1831天前

-

9

9

相关推荐

热门关注

-

- Xshell 6 简体中文

- ¥899.00-¥1149.00

-

- DaVinci Resolve Studio 16 简体中文

- ¥2550.00-¥2550.00

-

- Camtasia 2019 简体中文

- ¥689.00-¥689.00

-

- Luminar 3 简体中文

- ¥288.00-¥288.00

-

- Apowersoft 录屏王 简体中文

- ¥129.00-¥339.00