普林斯顿大学团队成功利用大型语言模型精确预测晶体特性,加速材料发现工作

发布于2024-11-30 阅读(0)

发布于2024-11-30 阅读(0)

扫一扫,手机访问

编辑 | X

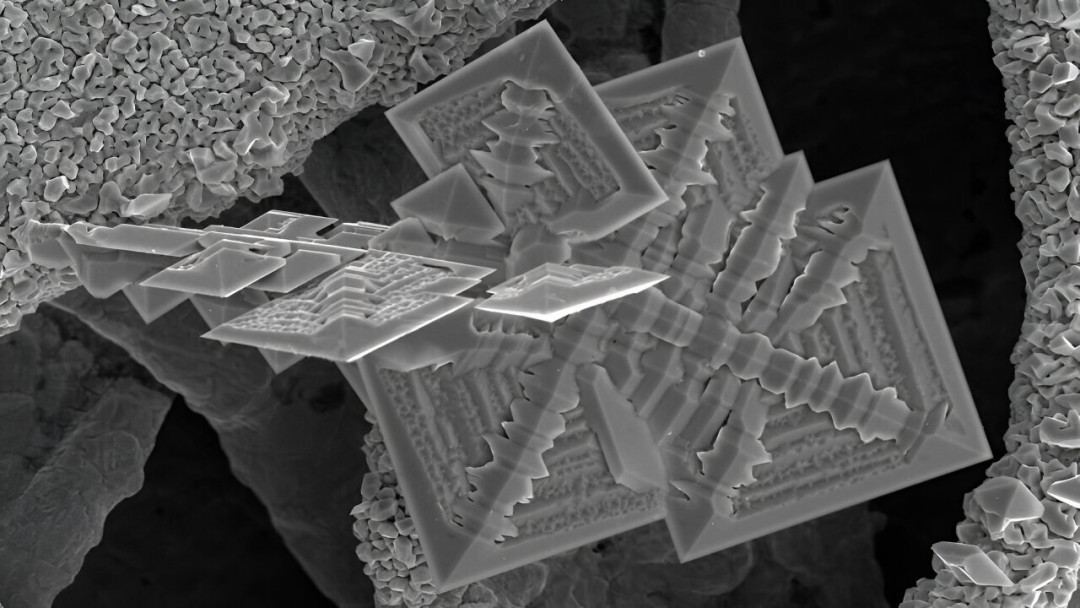

晶体特性的预测在晶体设计中扮演着非常重要的角色。目前,主要依靠图神经网络(GNN)对晶体结构进行建模来预测晶体的特性。虽然GNN非常强大,但是准确地模拟晶体内部原子和分子之间的复杂相互作用仍然是一个具有挑战性的任务。

虽然文本数据提供了丰富的信息和表现力,但晶体文本描述预测晶体特性的研究仍不充分,其中一个主要原因是缺乏公开数据。

普林斯顿大学的研究人员利用一种名为大型语言模型(LLM)的人工智能工具开发出一种新方法,用于预测晶体材料的行为。这个新方法结合了文本描述中的各种信息,例如原子之间键的长度和角度,以及电子和光学特性的测量结果等细节。通过这种综合分析,新方法可以更准确地预测新材料的特性,比现有的模拟方法更全面。这一突破有望加快新技术设计和测试的过程。

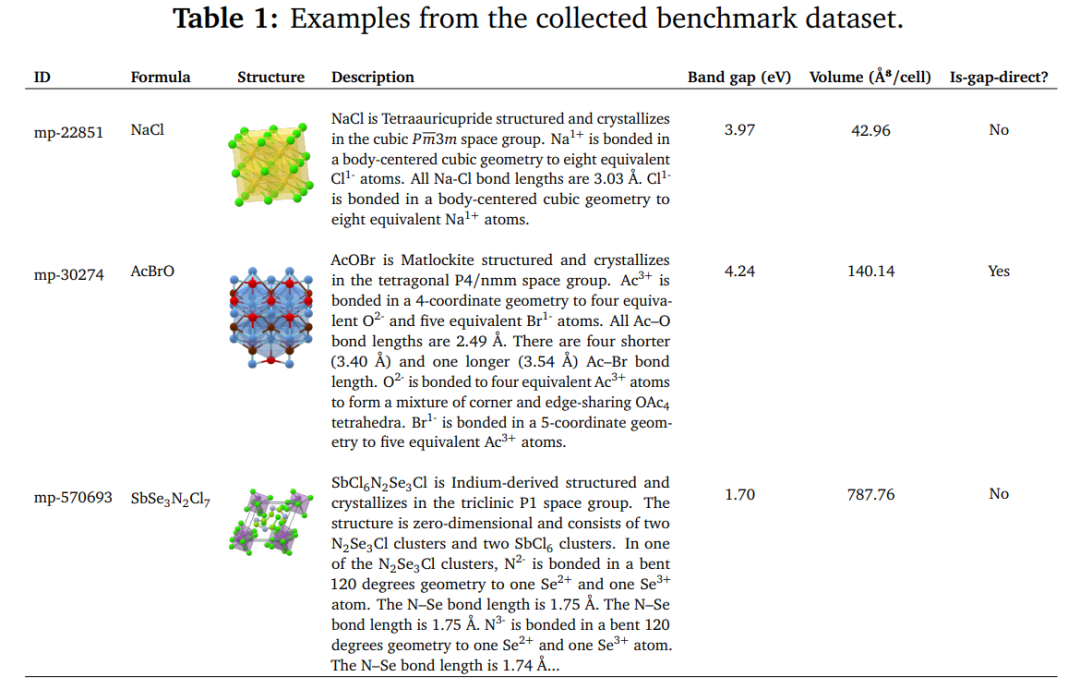

研究人员开发并公开了一个基准数据集(称为 TextEdge),其中包含来自 Materials Project 的 140,000 多个晶体的描述,然后,提出了 LLM-Prop,一种利用 LLM 的通用学习能力从文本描述中预测晶体的物理和电子特性的方法。

研究人员测试了该工具对先前研究的晶体结构(从食盐到硅半导体)特性的预测能力。已经验证了LLM-Prop的预测能力,并正在努力将其应用于新晶体材料的设计。

论文一作、普林斯顿大学计算机科学助理教授 Adji Bousso Dieng 表示,他们的方法代表了一个新的基准,可以加速材料的广泛应用。他们是第一个团队使用大型语言模型来解决这个问题的。

该方法于 2023 年 11 月 29 日,在波士顿举行的 the Materials Research Society's Fall Meeting 上提出。

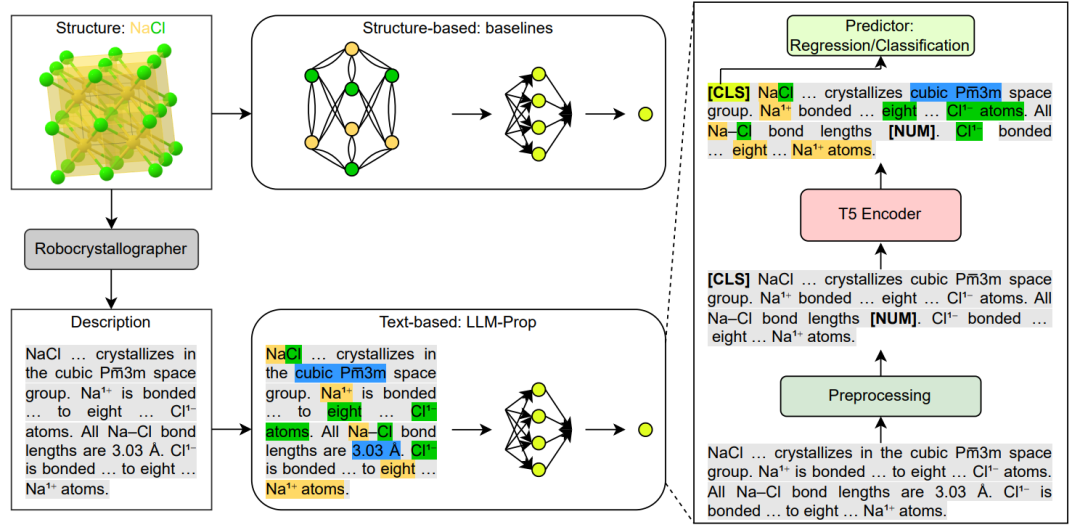

相关研究以「LLM-Prop: Predicting Physical And Electronic Properties Of Crystalline Solids From Their Text Descriptions」为题,发布到 arXiv 预印平台。

现有的基于人工智能的晶体特性预测工具依赖于图神经网络的方法,但这些方法的计算能力有限,无法充分捕捉晶体中原子之间的几何形状和键长的细微差别,以及由这些结构产生的电子和光学性质。

「我们在计算机视觉和自然语言方面取得了巨大进步,」Dieng 说,「但在处理 AI 图方面,我们还不是很先进。所以,我想从图转移到我们已经有了很好的工具的领域。如果我们有文本,那么我们就可以在文本上利用所有这些强大的大型语言模型。」

该研究的合著者、普林斯顿大学机械与航空航天工程教授兼负责创新的副院长 Craig Arnold 表示,基于语言模型的方法「为我们提供了一种全新的方式来看待材料设计问题。这实际上是关于,我如何获取人类已经开发的所有这些知识,以及如何处理这些知识以向前发展?它与我们当前的方法有本质上的不同,我认为这赋予了它很大的力量。」

研究的主要贡献概述如下:

研究人员收集、整理并公开一个基准数据集,其中包含大约 144K 晶体文本描述及其属性。 提出 LLM-Prop,这是一种高效微调的网络,使其能够在晶体特性预测方面实现最先进的性能,优于当前最好的基于 GNN 的晶体特性预测器。

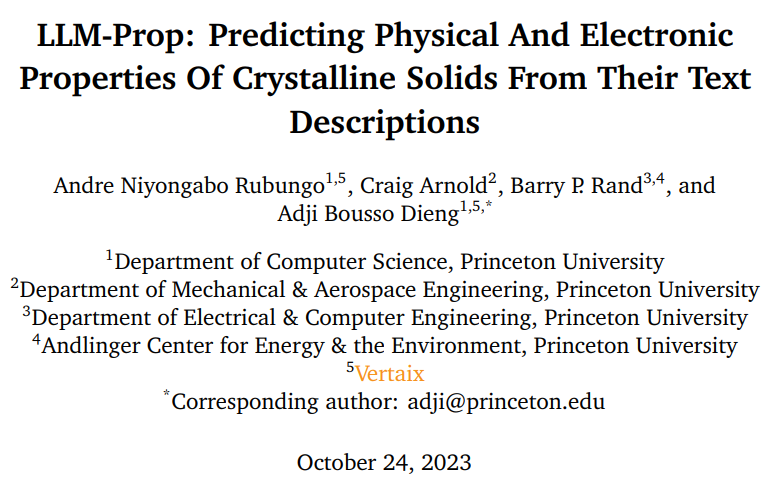

表 1:来自收集的基准数据集的示例。(来源:论文)

数据包含 144, 931 个晶体,将其分为 125, 098 个晶体用于训练,9,945 个晶体作为验证集,9,888 个晶体作为测试集。对于每个晶体,收集其 ID、结构信息、带隙、体积以及其带隙是直接还是间接的。使用 Robocrystallographer 提取了晶体文本描述。

LLM-Prop,是一个源自 T5 的精心微调的网络,用于晶体特性预测。通过大量实验证明,LLM-Prop 在预测晶体固体的物理和电子特性方面实现了卓越的性能,超越了当前最先进且使用广泛的基于 GNN 的架构(例如 ALIGNN)。

LLM-Prop 在所有任务上都能产生更好或相当的性能,包括 zero-shot 预测。尽管超参数少了 3 倍,LLM-Prop 的性能也优于经过微调的 MatBERT(一种特定领域的预训练 BERT 模型)。

LLM-Prop 在回归和分类任务上都优于所有基于 GNN 的基线。

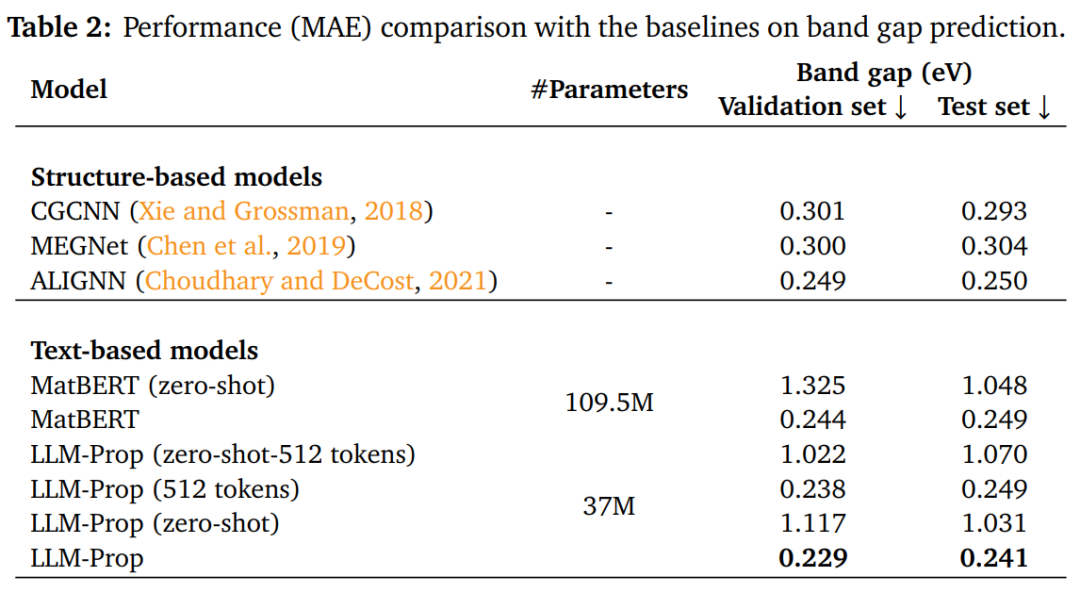

表 2:与带隙预测基线的性能 (MAE) 比较。(来源:论文)

对于带隙预测,LLM-Prop 在验证集和测试集上均优于性能最佳的基线 (ALIGNN),分别提高了约 8% 和 4%。

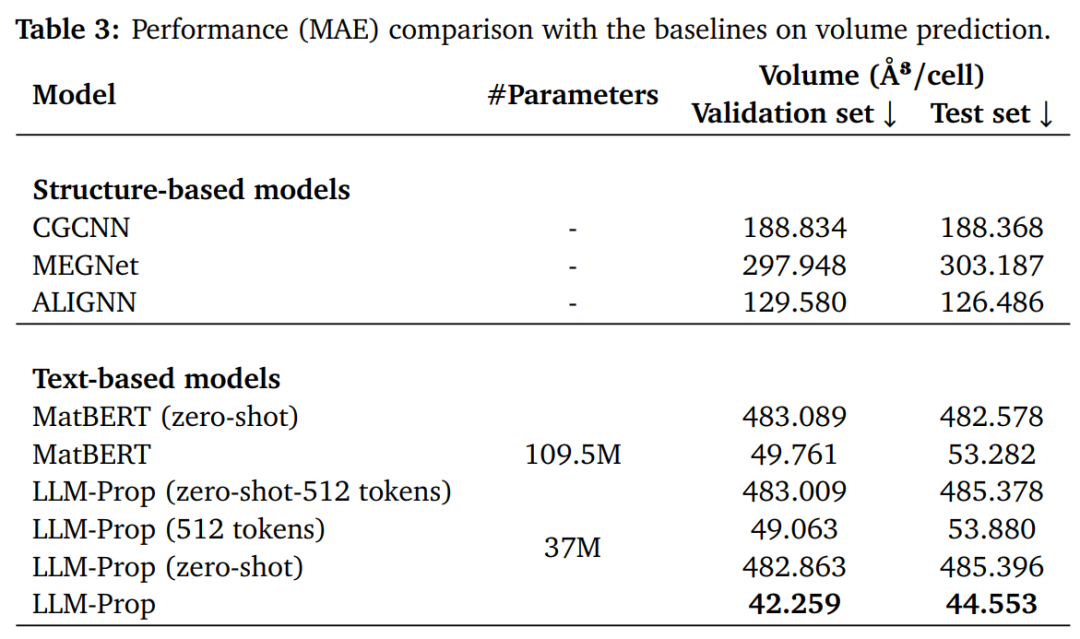

表 3:性能 (MAE) 与体积预测基线的比较。(来源:论文)

对于体积预测,LLM-Prop 还比验证集和测试集上的最佳性能基线 (ALIGNN) 分别提高了约 67% 和 66%。这种改进的可能原因可能是,与 GNN 相比,LLM-Prop 可以很容易地从文本描述中获取最重要的体积预测信息。

研究结果凸显了基于文本的方法在材料科学中的巨大潜力,基准文本数据 TextEdge 将助力这一新兴领域的研究。

参考内容:https://techxplore.com/news/2024-01-harness-large-language-materials-discovery.html

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

- 无需激光雷达数据监督的全新OccNeRF技术

- 写在前面&笔者的个人总结近年来,自动驾驶领域的3D占据预测任务因其独特的优势受到学术界和工业界的广泛关注。该任务通过重建周围环境的3D结构,为自动驾驶的规划和导航提供详细信息。然而,目前主流的方法大多依赖于基于激光雷达(LiDAR)点云生成的标签来监督网络训练。在最近的OccNeRF研究中,作者提出了一种自监督的多相机占据预测方法,名为参数化占据场(ParameterizedOccupancyFields)。该方法解决了室外场景中无边界的问题,并重新组织了采样策略。然后,通过体渲染(VolumeR

- 10分钟前 3D 自动驾驶 0

-

正版软件

正版软件

- 初步探索边缘人工智能的下一代应用程序

- AI已不再只是科幻电影的主题,它以惊人的速度应用于日常生活的各个方面。从个人关系到工作项目,AI正在逐渐改变我们的思维和行为方式。其中,一个典型的领域是NextGENEdgeAI(下一代边缘人工智能)应用。它通过排名、分类和设计等多种模式,提供身临其境、直观且有趣的使用体验,同时节省时间和资金。什么是NextGENEdgeAI?NextGENEdgeAI,又称为边缘智能或下一代人工智能,结合了边缘计算和人工智能技术,用于追踪和执行机器学习任务。它利用边缘设备的计算能力和数据处理能力,实现智能决策和分析,减

- 20分钟前 人工智能 边缘智能 Edge AI 0

-

正版软件

正版软件

- 超过5800名特斯拉个人投资者表态支持马斯克,支持2018年薪酬计划

- 2月6日消息,上周,特拉华州一名法官撤销了特斯拉首席执行官埃隆・马斯克(ElonMusk)2018年的560亿美元薪酬计划。随后,超过5800名特斯拉的散户投资者迅速行动,公开表达对马斯克及其薪酬方案的支持。这一裁决最初是由一名乐队鼓手发起的诉讼所引发的,他仅持有九股特斯拉股票,然而却引发了各方对此的不同反应。图源Pexels这些坚定支持马斯克的特斯拉投资者们有明确的目标:他们希望明确表达对马斯克2018年薪酬计划的支持,并强烈要求特斯拉董事会尽快为马斯克设计一套新的薪酬方案,使他能够拥有该公司25%有投

- 35分钟前 特斯拉 电动汽车 新能源汽车 0

-

正版软件

正版软件

- 波士顿动力Atlas升级:徒手搬运汽车配件的新能力

- 在如今颇为火热的人形机器人赛道,波士顿动力是较早入局的一位选手。近年来,全球关注的焦点之一是Atlas人形机器人的动态跑酷能力。此外,我们还见证了Atlas在模拟建筑工地上搬运物品。然而,目前Atlas仍然是一个开发平台,尚无法在实际工作中使用,其中一个原因是它的液压驱动设计的限制。波士顿动力最新演示视频揭示了Atlas和其他人形机器人在适当装备下能够完成高难度的操纵任务,包括操纵重物。在视频中,Atlas稳稳抓起一个比自己手臂还粗的汽车配件,搬运到目标位置:实际上,Atlas在很长一段时间内没有手指,而

- 55分钟前 产业 人形机器人 Atlas 波士顿动力 0

-

正版软件

正版软件

- 春节前,各寄递企业应及时投递已抵达派送网点的邮件快件

- 国家邮政局今日召开春运期间寄递服务保障工作再部署视频会,会议内容如下:会议强调,要加强对《2024年综合运输春运服务保障和安全生产总体方案》等工作的落实。各省(区、市)邮政管理局应加强对市(地)局的指导,全面了解各企业春运期间寄递服务的保障安排,包括分拨中心、网点、人员落实、驿站运营等方面情况。广东、浙江等业务量大省,要充分了解快递前端揽收、运营情况;遭受雨雪冰冻天气的省份,要督促指导企业做好干线疏运和末端投递工作,避免邮件快件积压。各寄递企业要做好工作调度和资源调配,在春节前将已抵达派送网点的邮件快件投

- 1小时前 17:45 快递 国家邮政局 0

最新发布

-

1

1

- 阿里追捧的中台,“热度”退了?

- 1816天前

-

2

2

- Overture设置踏板标记的方法

- 1653天前

-

3

3

- 思杰马克丁取得CleanMyMac中国区独家发行授权

- 1643天前

-

4

4

- IBM:20万台Mac让公司职工在工作中更快乐 更多产

- 1841天前

-

5

5

- 报道称微软一直在悄然游说反对“维修权”立法!

- 1807天前

-

6

6

- 美国怀疑华为窃取商业机密 华为:身正不怕影子斜

- 1803天前

-

7

7

- 三星被曝正与联发科接洽 A系列手机有望搭载其5G芯片

- 1818天前

-

8

8

- 环球墨非完成千万级融资 联合企业集团投资

- 1839天前

-

9

9

相关推荐

热门关注

-

- Xshell 6 简体中文

- ¥899.00-¥1149.00

-

- DaVinci Resolve Studio 16 简体中文

- ¥2550.00-¥2550.00

-

- Camtasia 2019 简体中文

- ¥689.00-¥689.00

-

- Luminar 3 简体中文

- ¥288.00-¥288.00

-

- Apowersoft 录屏王 简体中文

- ¥129.00-¥339.00