提升P图体验:南大、腾讯联手推出更稳定更准确的StableDrag拖拽技术

发布于2024-12-18 阅读(0)

发布于2024-12-18 阅读(0)

扫一扫,手机访问

在去年的五月份,一个名为 DragGAN 的研究引起了人工智能领域的关注。这项研究让图片变得“活”起来,只需动动鼠标就能实现。通过拖拽的方式,我们可以修改和合成出我们想要的图像,例如在下图中让一只狮子转过头来并张开嘴巴。这种技术的突破为图像编辑和合成带来了新的可能性,让用户能够以更直观的方式进行图像处理,从而创造出更加生动和有趣的作品。

这一研究成果源自华人学者领导的项目“Drag Your GAN”,最近发表在SIGGRAPH 2023会议上。该项目已在GitHub上获得了34.5k的Star。

项目地址:https://github.com/XingangPan/DragGAN

新加坡国立大学和字节跳动合作推出了DragDiffusion研究项目,利用大规模预训练扩散模型,显著提高了基于点的交互式编辑在实际场景中的适用性。这一技术的效果可以通过动图展示。

虽然取得了重要的成就,但类似的拖拽方案存在两个主要问题,即点跟踪不精准和动作监控不完善,可能导致拖拽效果无法达到预期。

南京大学和腾讯的研究者提出了一种判别式点跟踪方法,以解决现有系统的缺陷。通过基于置信的潜在增强策略,他们构建了一个名为StableDrag的拖拽编辑框架,提升了动作监督的稳定性和精确性。

判别式点跟踪方法能够准确定位更新的操纵点,有助于提升长程操纵的稳定性。另外,基于置信的潜在增强策略能够确保在所有操纵步骤中,优化的潜在变量具有高质量,从而提高系统的性能表现。

- 论文标题:StableDrag: Stable Dragging for Point-based Image Editing

- 论文地址:https://arxiv.org/pdf/2403.04437.pdf

- 项目地址:https://stabledrag.github.io/

得益于这些独特的设计,研究者实例化了两种类型的图像编辑模型:StableDrag-GAN 和 StableDrag-Diff。这两个模型在 DragBench 上进行了广泛的定性和定量评估,结果都显示出更加稳定的拖拽效果。

从下面视频中,我们可以看到 StableDrag-GAN 的拖拽全过程。

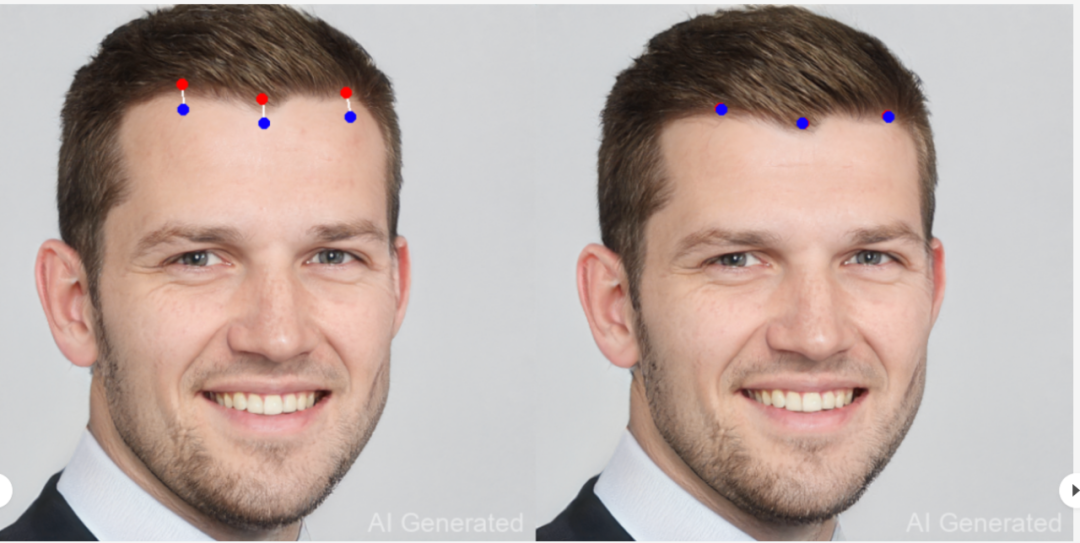

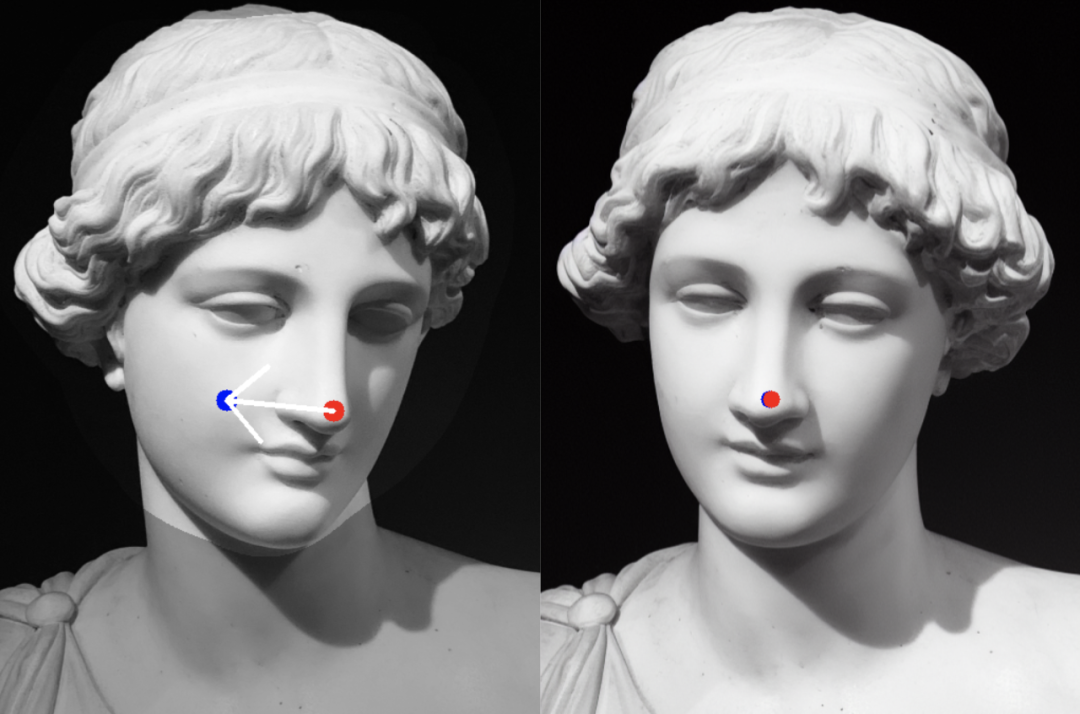

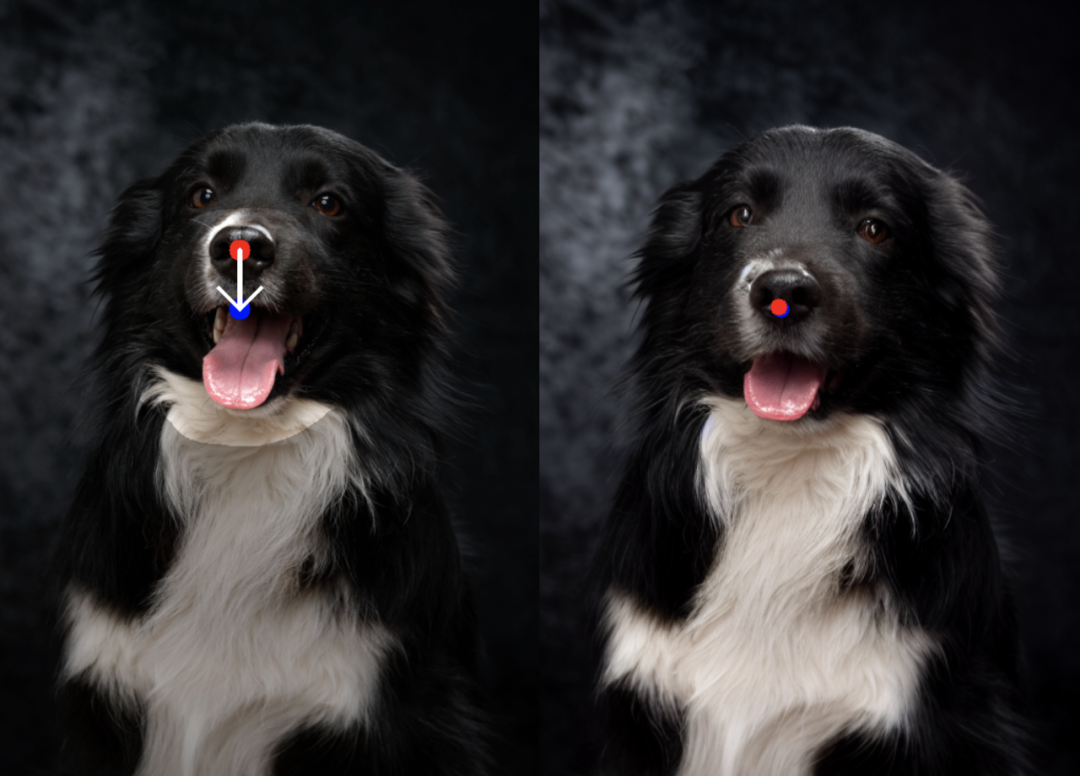

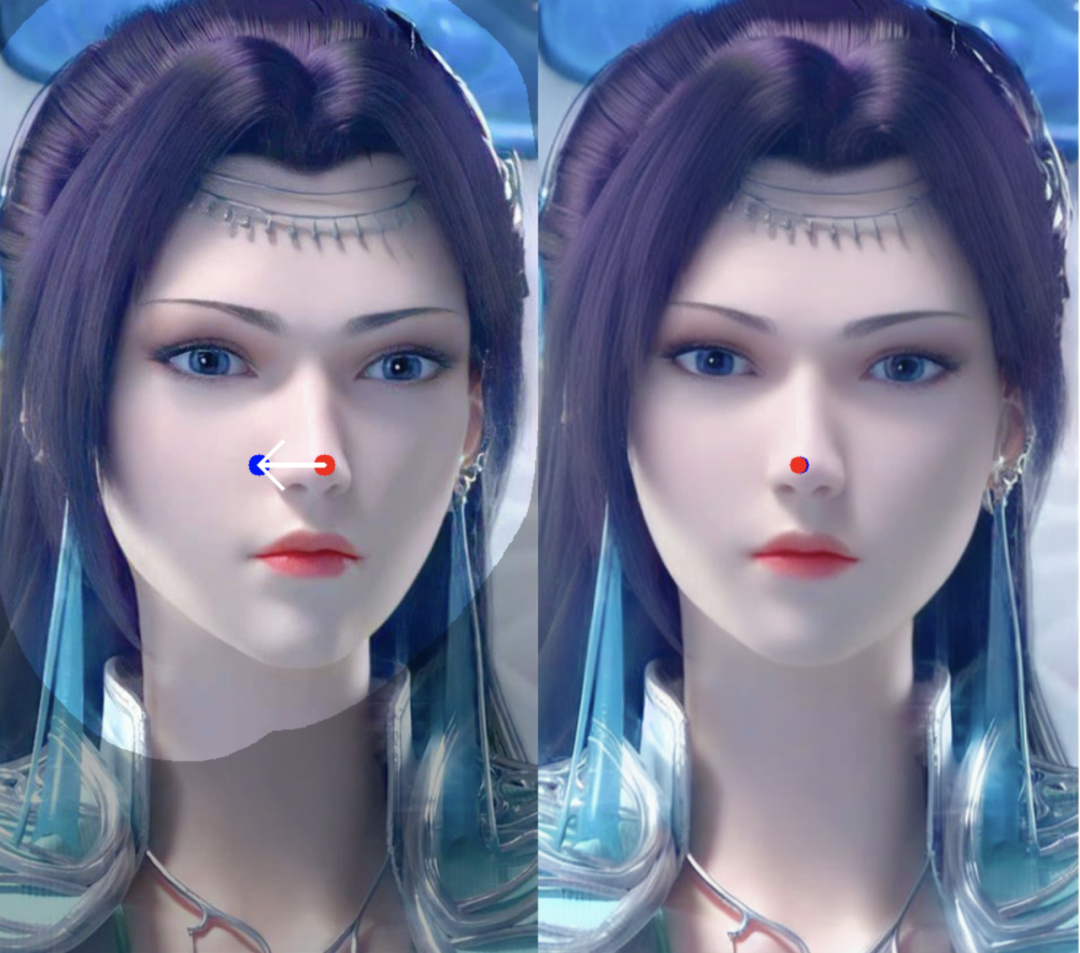

如下为 StableDrag-GAN 的更多拖拽示例。

StableDrag-Diff 的拖拽示例如下所示。

方法介绍

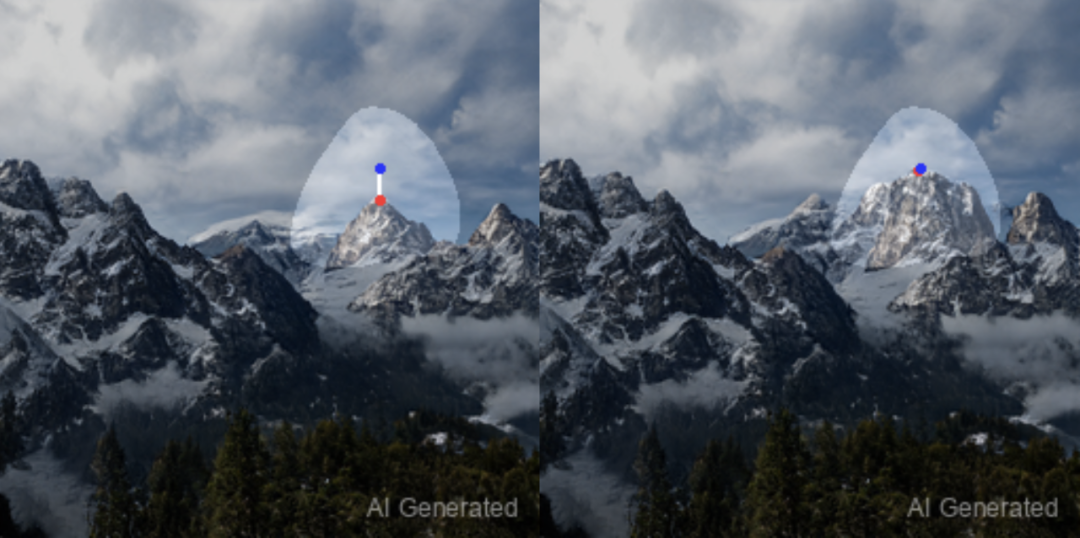

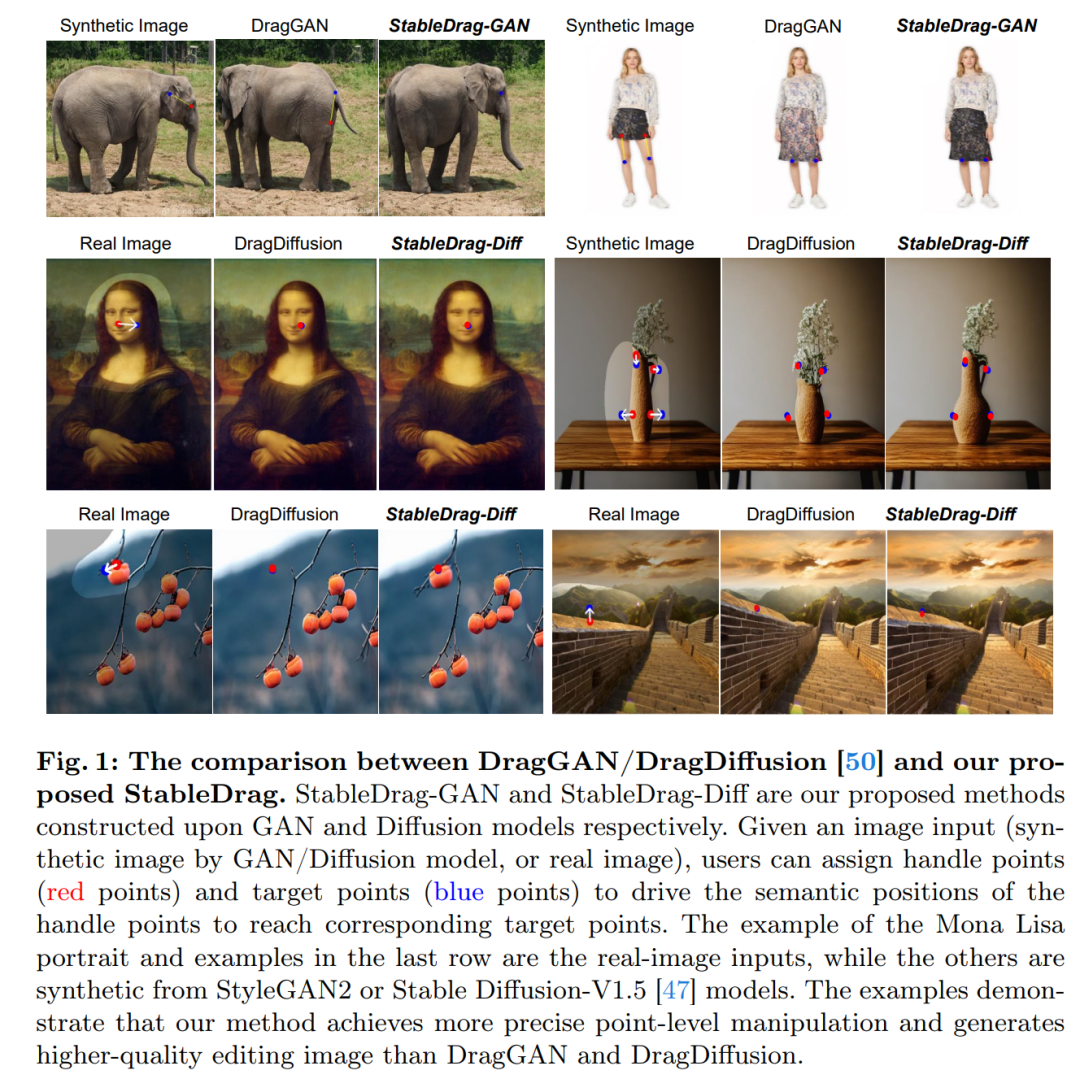

如图 1 所示,由于不精确的点跟踪和不完整的动作监督,DragGAN 和 DragDiffusion 对图像的编辑质量不高。因此,在这项工作中,本文将注意力集中在当前的拖拽技术上,以实现更稳定和更精确的图像操作。

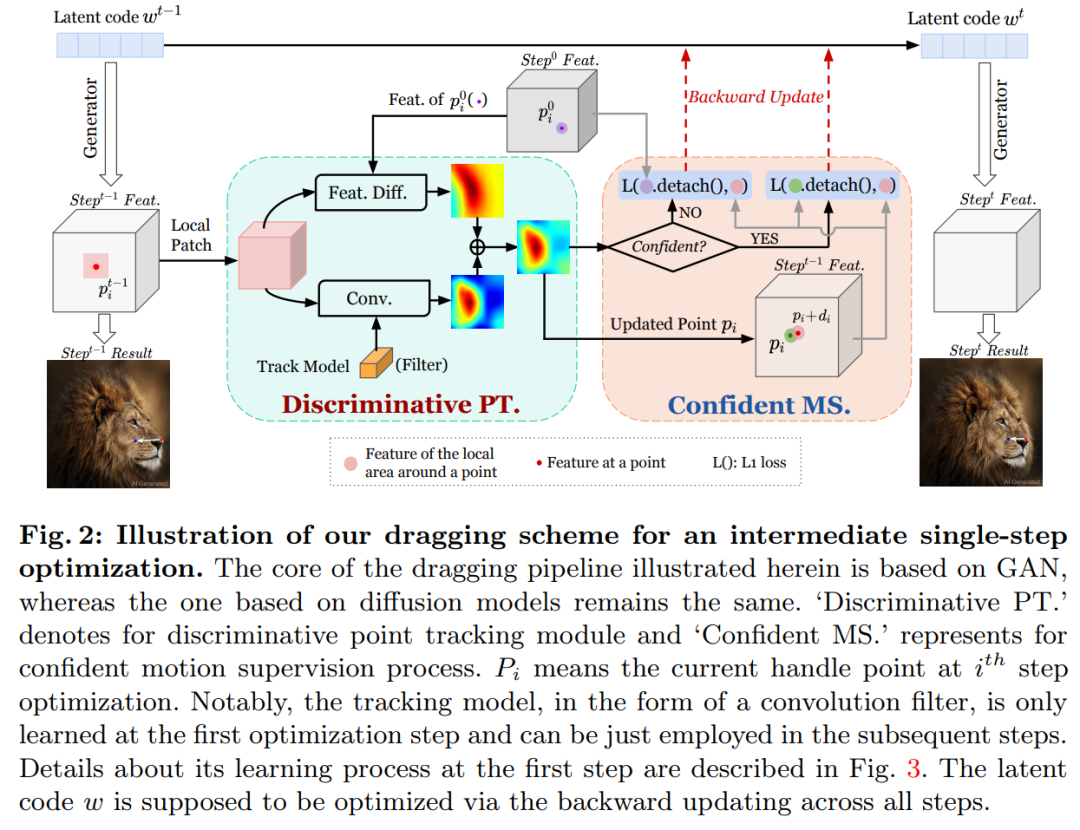

拖拽 pipeline 如图 2 所示,包括判别点跟踪模块( Discriminative PT )和置信动作监督模块( Confident MS )。

判别点跟踪

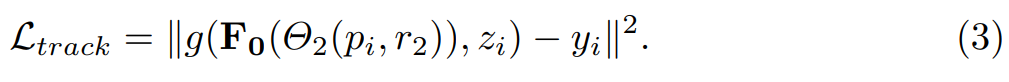

本文提出了一种更具辨别力但简单的点跟踪算法。在本文的设计中,点跟踪模型构成卷积层的权重,并提供点分类得分作为输出。具体来说,本文建议学习一个函数 ,其中 g 为卷积函数,

,其中 g 为卷积函数, 为当前操纵点( handle point ) p_i 周围的局部 patch,z_i 为学习到的跟踪模型。详细流程如上图 2 所示。

为当前操纵点( handle point ) p_i 周围的局部 patch,z_i 为学习到的跟踪模型。详细流程如上图 2 所示。

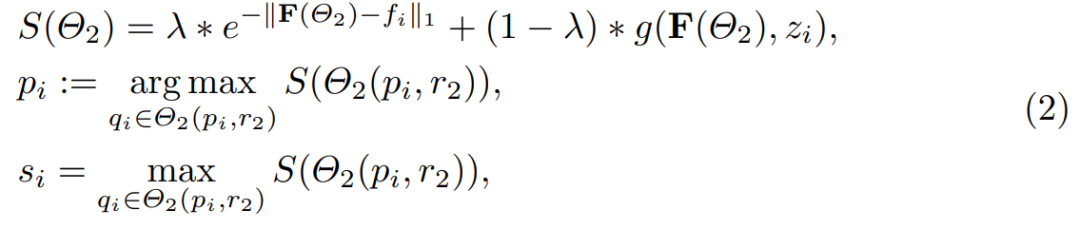

在此过程中,跟踪点 p_i 的更新方式为:

跟踪模型 z_i 是一个大小为 1 × C × 1 × 1 的卷积滤波器,其学习过程概述如图 3 所示。本文使用 f_i 初始化 z_i 并在以下损失的监督下更新权重:

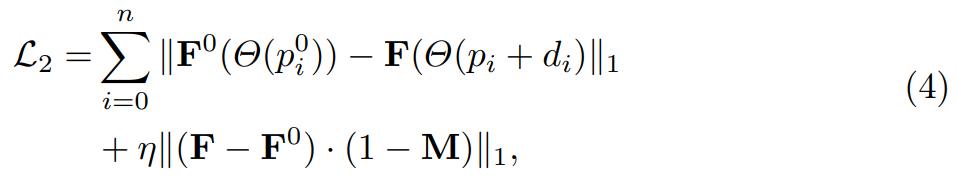

置信动作监督

本文提出了一种基于置信度的潜在增强策略,如图 2 所示。首先,本文引入跟踪得分最大值即 s_i,来表示当前的监督置信度,以及置信度分数在 step-1 产生增强策略的阈值。通常,当模型足够自信地识别当前状态时,本文会采用论文中等式(1)的原始动作监督。如果当前的置信度得分低于预定义的阈值,则采用初始模板进行监督。具体强化监督定义为:

实验结果

研究者基于 PyTorch 实现了 StableDrag-GAN 和 StableDrag-Diff,实验中使用了一块英伟达 V100 GPU。

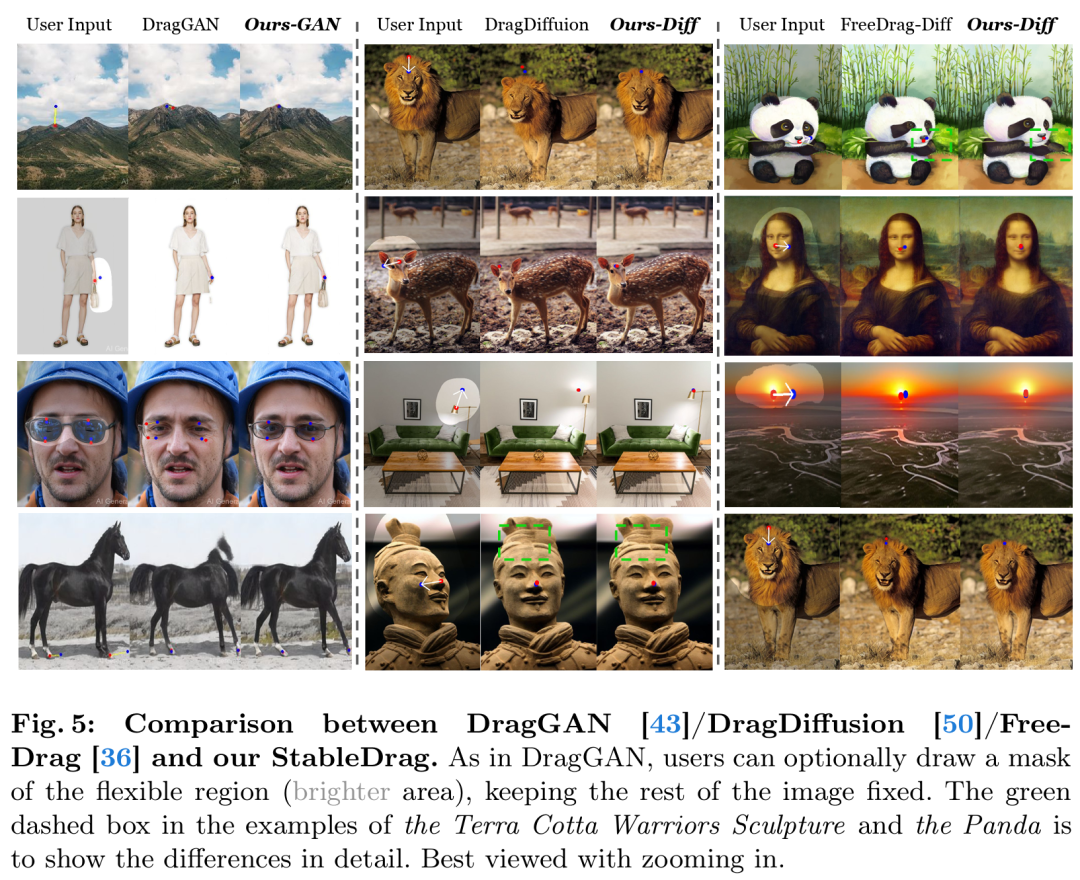

下图 5 展示了 DragGAN 与 StableDrag-GAN、DragDiffusion 与 StableDrag-Diff、以及 FreeDrag-Diff 与 StableDrag-Diff 三组模型之间的定性比较。

可以看到,本文的 StableDrag 方法可以更精准地将操纵点移动到目标点,例如山峰、狮子下巴、小鹿额头和灯泡。同时,StableDrag 可以生成更高质量和更高保真度的编辑结果,比如保持手提包、眼镜、马和兵马俑的外观。

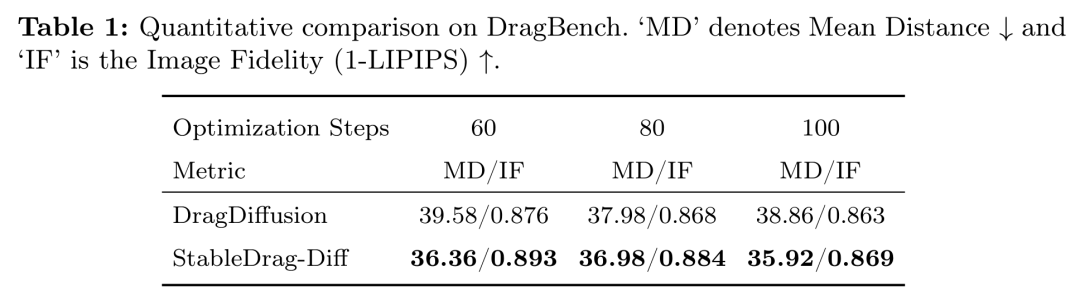

研究者在 DragBench 基准上对 StableDrag 方法进行了定量评估,该基准包含 205 个具有预定义拖拽点和掩码(mask)的样本。

如下表 1 所示,在 3 种不同的优化步骤设置下,StableDrag-Diff 始终能够优化 DragDiffusion。

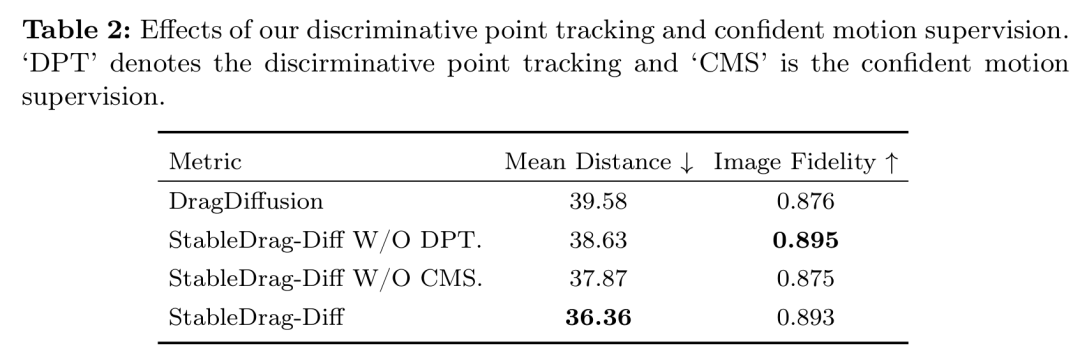

这进一步表明:通过置信动作监督和判别式点跟踪,StableDrag 可以在编辑准确性和内容一致性方面实现有潜力的结果。

除了定性和定量评估之外,为了验证本文方法的有效性并展开深入分析,研究者通过「基于 GAN 和扩散模型的定性可视化」以及「基于扩散模型的 DragBench 定量评估」,进行了详细的消融实验。

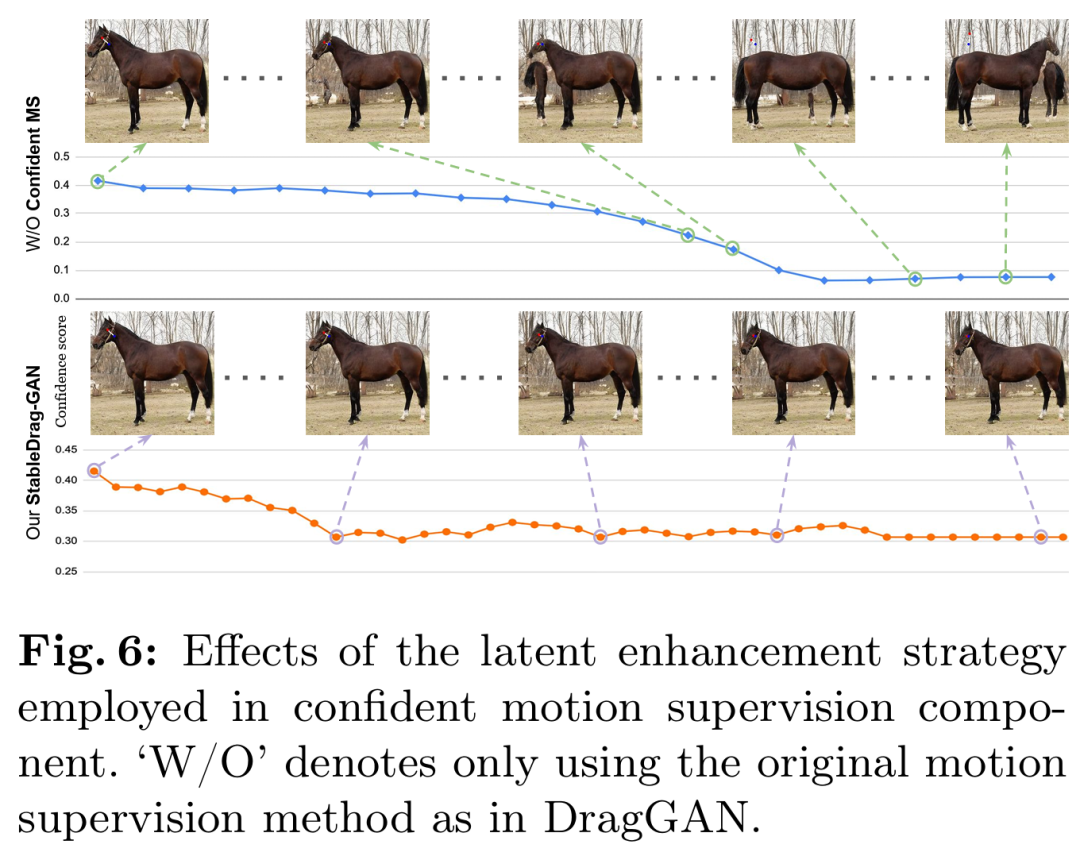

首先是置信动作监督。研究者首先进行了基于 StableDrag-GAN 的马编辑实验,如下图 6 所示,随着置信度得分逐渐降低,没有置信度动作监督模块的 StableDrag 编辑的图像质量较低。

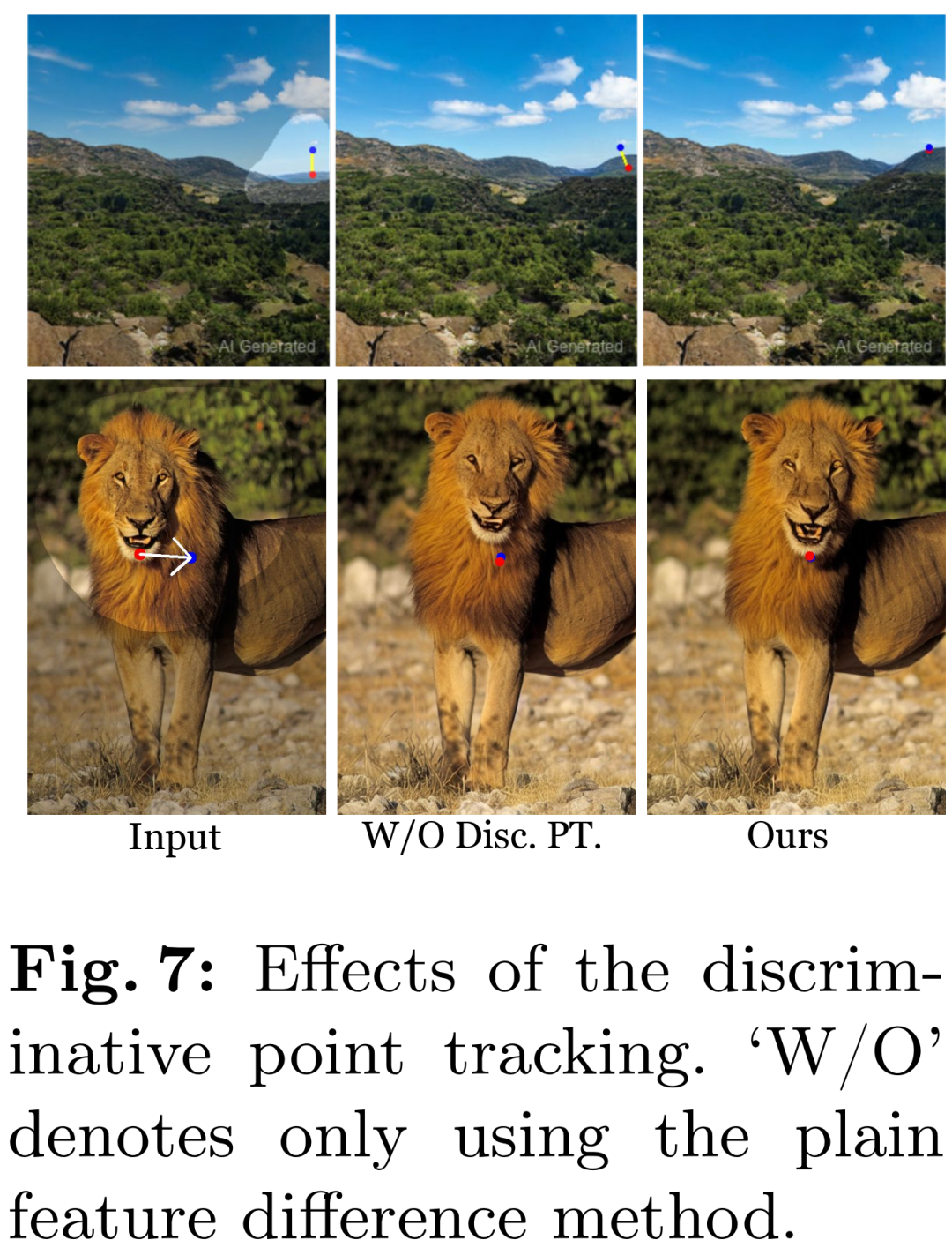

其次是判别点跟踪。图 7 和表 2 评估了 StableDrag 和没有判别跟踪模型的 StableDrag。我们可以看到,没有判别跟踪模型的 StableDrag 可能会受到背景干扰点的误导,导致结果不准确。

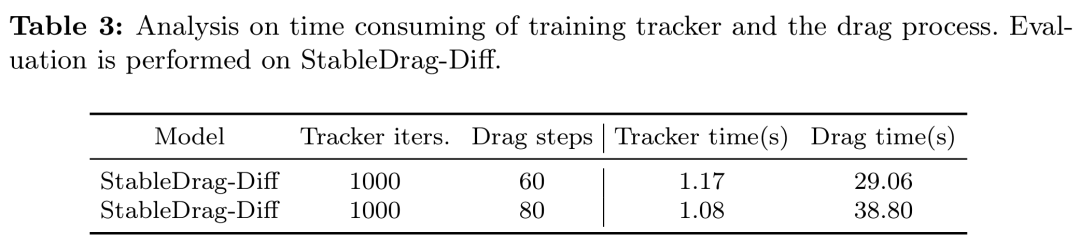

最后是跟踪模块的实用性。该研究提出的点跟踪器在公式和实现上都很简洁。如表 3 所示训练跟踪器(大约仅 1 秒)花费的时间远少于拖拽过程。

更多技术细节和实验结果请参阅原论文。

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

- 小鹏P7i 702 Max鹏翼版正式上市,24.99万元起售挑战电动轿车市场

- 小鹏汽车P7i702Max鹏翼版于3月25日正式发布,售价定为24.99万元。这款新车型是在702Max长续航车型基础上打造的,最引人注目的地方在于其独特的“剪刀门”设计。这一设计不仅提升了车辆的时尚感,还为乘客进出车辆带来了全新体验。新车配备了强劲的动力系统,最大输出功率可达276马力,峰值扭矩达440Nm。搭载86.2千瓦时的电池,在CLTC工况下,续航里程可达702公里,为驾驶者带来稳定而持久的驾驶享受。除了出色的动力系统,小鹏P7i702Max鹏翼版在配置上也毫不逊色。从外观上看,新车提供了星暮紫

- 6分钟前 小鹏汽车 0

-

正版软件

正版软件

- Yala:链接比特币流动性与生息稳定币

- TL;DR比特币的最初设计优先考虑安全性和去中心化,而不是智能合约和DeFi应用程序等复杂功能。因此,Yala在Ordinals协议上创建一种模块化架构,同时集成去中心化索引器网络和Oracle,为比特币引入智能合约能力,从而发行稳定币$YU。基于这种模块化设计,$YU能够自由地参与任何链上的DeFi活动,从而释放比特币巨大的流动性。Yala的目标是为比特币建立一个模块化的DeFi收益聚合器,通过联邦投票索引器(最终建成完全去中心化索引器)以及带有阈值签名的比特币保险库等机制来确保安全性和去中心化,同时通

- 11分钟前 0

-

正版软件

正版软件

- 比特币ETF结束连5日净流出!减半后币价无重大波动

- 本站(120btC.coM):在比特币减半前夕,现货ETF结束了自12日以来的五日净流出,比特币减半后并没有明显波动,截稿前价格约64,172美元。比特币现货ETF终结连五日流出SoSoValue数据显示,比特币现货ETF结束自12日以来的五日净流出,4月19日总净流入为5,956万美元。各家ETF4月19日数据如下:灰度GBTC:-4580万美元贝莱德IBIT:2,930万美元富达FBTC:5,480万美元VanEck的HODL也有-180万的净流出。比特币现货ETF流量比特币自高点回撤近两成比特币近期

- 26分钟前 稳定币 比特币减半 主流币 莱特币减半 0

-

正版软件

正版软件

- 数字货币哪些币种比较好

- 以下是最适合初学者的顶级数字货币:比特币(BTC):去中心化、稀缺性、长期价值以太坊(ETH):可编程区块链平台币安币(BNB):交易平台代币卡尔达诺(ADA):可扩展、高效的平台索拉纳(SOL):高速、低成本的平台在选择币种时,需考虑市场份额、用例、技术、团队和社区,以及个人风险承受能力。

- 36分钟前 0

-

正版软件

正版软件

- btc钱包地址是什么类型钱包

- BTC钱包地址是属于非托管钱包,用户完全控制自己的资金,对私钥保管负责。

- 51分钟前 0